La Realidad Virtual tiene todo de realidad. Sin medias tintas: podemos acercarnos a la sección tecnológica de cualquier centro comercial y comprobarlo. Es el nuevo gadget rey, algo tan actual como futurista. Sí, existe un abismo desde unas Cardboard a unas HTC Vive o las propias VR1 que comercializa Orange, pero a nivel conceptual estamos ante un escenario idéntico: viajar sin desplazarnos, sentir sin vivirlo en las carnes, ser parte en escenarios, lúdicos o no, donde nuestra percepción esté lo suficientemente distorsionada como para creer en ellos.

Pero la incertidumbre sigue ahí. ¿Estamos listos sí o no? Después de décadas de promesas ampulosas, de «mundos inmersivos» que no eran tal, nos preguntamos en qué punto estamos. Ya no se trata sólo de que la tecnología sea apta para dar este salto de gigante, sino que nosotros, los usuarios, estemos listos a nivel biológico, y como consumidores seamos capaces de asumirla sin gastos prohibitivos.

Para conocer estas tecnologías desde dentro, entender de dónde vienen y a dónde van, y para saciar esa curiosidad que a cualquier adopter le despierta cuando está ante algo nuevo, hemos charlado con un verdadero experto en VR: Fernando Conde Gómez. Preparémonos para aprender de conceptos como “asynchronous spacewarping” o “extremely high frequency”. Fernando ha sido testigo de todos esos grandes saltos tecnológicos, formando parte de una generación que empezó a escuchar música en cassette y hoy vive en la nube, parte de ese torbellino que vivió la Realidad Virtual como ensoñación de publicista y ahora espolea sus avances desde dentro.

Si quieres hacer algo popular, haz que jueguen con ello. Esta parece una máxima común: la gamificación es la puerta de entrada para cualquier tecnología. Y los videojuegos son un elemento diferencial en esta ecuación. Tal vez podamos pensar en la Realidad Virtual y en la instrucción de pilotos, en la formación de cirujanos o en el entrenamiento de astronautas, pero los videojuegos son el entorno idóneo para cualquier tipo de usuario.

La gamificación es la puerta de entrada para cualquier tecnología

Biz Dev en Sngular, empresa española de proyectos en innovación, desarrollo y habilitación tecnológica, Fernando ha trabajado en la industria del videojuego desde todos los ángulos posibles: el perfil crítico, el analítico y el consultor. Pero nada mejor como sus propias palabras para conocer su trayectoria.

Antes de nada, para contextualizar el presente: ¿de dónde viene el Fernando experto en tecnología?

A pesar de que ahora estoy en consultoría, donde mi puesto (en lo relativo a VR) es el de Responsable de Innovación y Desarrollo de Negocio para VR, desembarqué en este campo hace tres años, después de unos cuantos trabajando en el sector del videojuego. Estuve escribiendo para diversos medios (principalmente Meristation) desde 1997 hasta 2004, organicé una Campus Party —en 1999, la última que se celebró en Málaga antes de su mudanza a Valencia— y empecé a colaborar con FX Interactive en el año 2000, en lo que se acabó convirtiendo en un trabajo a tiempo completo, pues estuve trabajando allí como Productor y como Responsable de Nuevo Producto hasta el año 2013, lanzando medio centenar de títulos entre los que tuve la enorme suerte de poder trabajar con algunos como Sacred, la saga Imperivm, Panzers, Drakensang, Runaway 2, Hollywood Monsters 2, Tropico 3 y 4, X-Plane… Vamos, que lo de los videojuegos no me viene sólo por afición.

Espera, ¿de escribir en MeriStation a trabajar en FX?

Empecé a colaborar con MeriStation a mediados de los 90 porque formaba parte del Grupo Universitario de Informática de la Universidad de Valladolid y teníamos acceso a Internet, algo que en aquella época todavía no estaba demasiado extendido (…) Estuve escribiendo noticias, análisis, avances, artículos sobre hardware, moderando el foro de estrategia… Siempre relativo al PC. Al final fue una relación de 7 años (…).

Con FX la relación comenzó gracias a Meri: buscaban un «asesor en Star Trek» para el lanzamiento de The Fallen y Pablo de la Nuez, el director Editorial, leyó uno de mis artículos y se puso en contacto conmigo. La colaboración fue muy bien para ambas partes y desde ese momento me estuvo tentando para trabajar con ellos. Al final, cuatro años después, me planteó un ultimátum: necesitaban un jefe de proyecto; si quería, el puesto era mío, si no, me dejaba de intentar convencer.

El resto es historia: 10 años trabajando con uno de los mejores equipos de desarrollo y producción de videojuegos que ha habido nunca en España, que fueron como un máster en muchísimas cosas. Al final, ejercía de productor y de responsable de Nuevo Producto, lo que me daba una perspectiva realmente única del producto: veía el lado de negocio, veía el lado de la gestión del proyecto, la parte artística, el desarrollo, asistía a los doblajes, viajaba a ferias… Fue un periodo hiper-intenso, que cambió totalmente mi vida.

¿Y dónde entra la Realidad Virtual en esta ecuación?

Un amigo de la infancia con el que estudié la carrera me planteó cambiar al mundo de la consultoría; así entré en contacto con Sngular. Coincidió que necesitaban una persona para gestionar un proyecto de desarrollo: la banca online de un gran banco norteamericano. Yo tenía mucha experiencia gestionando equipos desperdigados por el mundo en inglés, por lo que decidieron arriesgarse a contratarme. Y afortunadamente, mi amigo tenía razón: Sngular nació como una unión de varias empresas muy diversas, cuyos puntos en común eran estar formadas por gente muy apasionada por lo que hace y centrar su actividad en un mundo tecnológico. Los clientes son también muy diferentes que en el sector del videojuego, claro: grandes bancos, empresas financieras, de seguros, de infraestructuras, aeroespaciales, del sector retail…

A principios de este año se incorporó a Sngular una nueva empresa: una start-up que lleva ya trabajando en VR/AR casi 3 años, lo que en este sector es como decir que toda la vida. Con mi pasado en el sector del videojuego y mis conocimientos sobre la tecnología, tenía sentido que yo participase del nuevo área, en el área de innovación, algo con lo que yo, por supuesto, estoy encantando».

Marearse o no marearse, he ahí la cuestión

Quiero empezar con una pregunta incómoda. No vamos a esconderlo bajo la alfombra: ¿por qué nos mareamos unos usuarios y otros no cuando usamos unas gafas de Realidad Virtual?

Lo primero es dejar claro que todos nos mareamos (todos sufrimos cinetosis): la diferencia es el umbral a partir del cual lo experimentamos. Por ejemplo, considero que yo tengo un umbral medio-alto, pero experimentando con la cámara en Unity me he llegado a poner verde. Todo depende de la dureza de la interacción a la que te expongas.

Las experiencias que llegan a los usuarios, si están bien ajustadas, no deberían provocar mareo. Pero con la VR pasa lo mismo que con los mareos en los transportes: hay quien se marea en el coche y hay quien no.

¿Se puede hacer algo, mediante el hardware, para evitar tales mareos?

Cuando se producen diferencias muy evidentes entre lo que nuestros ojos le cuentan al cerebro y lo que éste recibe del sistema vestibular, las cosas se ponen muy feas. No está muy clara la razón de que provoque malestar físico, pero sí que está claro qué lo provoca: estamos engañando a los ojos y al oído, pero ignorando al sistema vestibular que se encarga del equilibrio.

Desde ese punto de vista, el hardware ahora mismo no tiene mucho que hacer: la estimulación del sistema vestibular no está en el roadmap de ninguna tecnología, que yo sepa, aunque hace ya 10 años que el Mount Sinai publicó investigaciones muy interesantes sobre estimulación vestibular galvánica. Básicamente conseguían engañar de manera muy primitiva al sentido del equilibrio.

Por lo demás, se trata de evitar darle al cerebro estímulos muy divergentes. El framerate es absolutamente crítico, porque un framerate demasiado bajo hace que el cerebro perciba que está girando la cabeza pero los ojos le digan que no —durante un corto periodo de tiempo, que el ojo es capaz de percibir, la imagen no cambia aunque estamos moviendo la cabeza—. Eso es un showstopper directo, y la mayoría de los esfuerzos que se han hecho han sido en esa dirección, incluso llegando al extremo de alterar los pipelines gráficos para permitir “falsear” los framerates de cara al ojo. Técnicas de “interrupción” (preemption) de la GPU y “asynchronous timewarping” —o en el último SDK de Oculus, el “Asynchronous Spacewarping“—, al final lo que hacen es decirle a la GPU “mira, como no llegas a pintar el frame a tiempo, ya me ocupo yo: cojo el anterior frame y lo muevo en la dirección en la que se haya movido la vista”. De hecho, en los pipelines modernos, cuando el frame está terminado, antes de presentarlo, se calcula el movimiento que ha habido en la cabeza para ajustarlo y minimizar el lag.

La razón de los mareos es que estamos engañando a los ojos y al oído, pero ignorando al sistema vestibular que se encarga del equilibrio

Otra mejora importante vendrá por el lado de las ópticas. El cerebro identifica la profundidad por medio de dos mecanismos. El principal es el paralaje, la diferencia entre las imágenes que recibe del ojo izquierdo y el derecho al que conseguimos engañar mostrando dos imágenes diferentes. Pero hay un mecanismo secundario: el enfoque. El ojo ajusta unos músculos que deforman la córnea para lograr el enfoque correcto a diferentes distancias, pero en VR no hay diferentes distancias. Desde el punto de vista del plano de enfoque, todo está a la misma distancia. Esto hace que el cerebro perciba que algo no va bien, y aumenta la fatiga.

La solución a este problema vendrá dada por los visores que hacen uso de tecnología de “campo de luz” (light-field), que usan matrices de microlentes para proporcionar a los ojos múltiples profundidades de enfoque —y que, además, tienen la ventaja de ser mucho más finas que las lentes fresnel empleadas ahora mismo—. Es lo que se supone que Magic Leap va a poner en el mercado en algún momento».

viviendo la experiencia

Tengo entendido que, debido a estos condicionantes, no podemos jugar más de 30-40 minutos. De ahí que la producción de contenido se esté enfocando más hacia “experiencias” que a largas sesiones de juego o consumo multimedia. ¿Se va a superar este escollo en el futuro?

Como todo, esto es variable. Yo sé de gente que se pega sesiones de juego de toda la tarde sin experimentar “secuelas físicas” —más allá de unas buenas agujetas— y yo mismo he pasado sesiones de casi una hora —y no han sido más largas porque no tengo un equipo de VR en casa—. De hecho, casi me resultó más cansado el peso del visor y el calor generado por la pantalla.

En cuanto a tecnología, me remito al punto anterior: estamos en la infancia. En 5 años los visores habrán evolucionado muchísimo, y en 10 años los visores actuales nos darán risa, los veremos como a primitivos inventos victorianos. Todas las mejoras en los visores van orientadas a mejorar la experiencia y reducir la fatiga.

Y no nos olvidemos de que también hay un factor de “acostumbrarse”. Yo todavía recuerdo la primera partida al Quake 2 que me jugué con mi flamante nuevo monitor de 19”, y el mareo que me provocó: llegué a pensar que no podría jugar en ese monitor. Y ahora juego en un 30».

De hecho, se habla de que la VR traerá un género en sí mismo, que todo depende de la creatividad con la que los desarrolladores apliquen las herramientas. Juguemos a soñar el futuro, ¿hasta dónde se podría llegar con la VR, qué podría llegar a hacerse sin salir de casa?

Como con todo nuevo soporte audiovisual, estos primeros intentos se basan en “extender” las experiencias de juego previamente existentes a este nuevo formato, pero es evidente que el formato traerá nuevas formas de narrativa y de interactividad. El mayor shock creativo está siendo que no podemos imitar experiencias realistas, que era lo que esperábamos de la VR, por las limitaciones tecnológicas del formato. No podemos hacer un Call of Duty o un Battlefield, porque sería físicamente insoportable para una gran parte de la audiencia.

Aquí es donde se abre el campo nuevo: tenemos que experimentar con las posibilidades, ver hasta dónde podemos llegar e inventarnos nuevas formas de resolver lo que en el mundo real hacemos de una manera concreta sin provocar náuseas en la VR.

Si soñamos con el futuro, tenemos mucha cancha. No sabría prever qué experiencias o nuevas formas de jugar, o narrar, se van a sacar de la manga los productores y desarrolladores —si lo supiese estaría trabajando en ello con mucho ahínco—, pero sí que puedo aventurar lo que la tecnología está trabajando en traernos, y creo que la realidad superará a la ficción en un marco temporal que vivirá nuestra generación. La tendencia es a disponer de cada vez más potencia de cálculo y mejores algoritmos para simular la realidad. Llegará un momento en el que será muy difícil distinguir lo real de lo virtual.

Los visores se irán reduciendo hasta la casi desaparición, la AR se integrará en nuestro flujo de vida y trabajo diario como hoy lo hace el móvil, no concebiremos nuestra vida sin ella, y la tecnología de displays cambiará de manera radical. Las lentillas ya están en fase de prototipo; muy primitivo, pero prototipo. Y existen investigaciones prometedoras en el campo de los interfaces directos humano-máquina, que van a acelerarse muchísimo por los avances, cada día más rápidos, en los campos de la bioingeniería, la nanotecnología y las redes neuronales artificiales. Yo, por lo menos, ya no los veo como ciencia-ficción.

En 5 años los visores habrán evolucionado muchísimo, y en 10 años los visores actuales nos darán risa, los veremos como a primitivos inventos victorianos

Pongamos un poco de perspectiva: hoy en día percibimos como muy significativo el aumento de resolución de Full HD a 4K. 4 veces más resolución: es “otro nivel”. Pues de los ordenadores con los que yo jugaba y programaba de pequeño a los de hoy la resolución se ha multiplicado por 24, la memoria por más de 100.000 y la potencia de procesador por más de medio millón, sólo atendiendo a las métricas más simples. Ahora extrapolemos lo que tenemos ahora y pensemos lo que podría ser en 20 o 30 años.

De cables FÍSICOS y conexiones neuronales

Nos tocará recordarnos aquello de Arthur C. Clarke: “Toda tecnología lo suficientemente avanzada es indistinguible de la magia”. Sigamos por la línea de la VR: ¿por qué hay que renderizar el vídeo de cada ojo de manera independiente y por qué unas gafas (LG 360 VR) permiten ajustar la distancia interpupilar y otras (GEAR VR) no lo hacen o no lo necesitan?

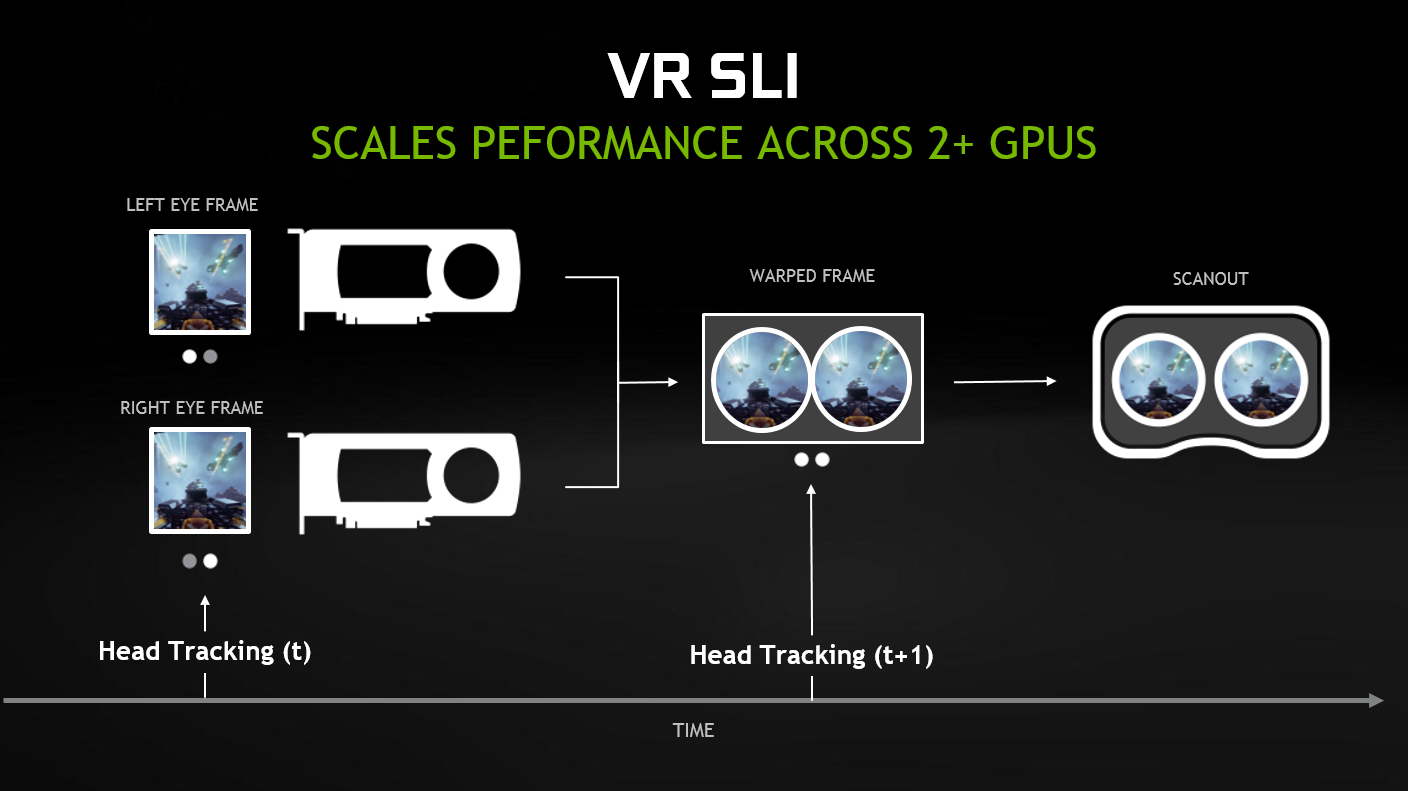

Lo del render para cada ojo es directo: necesitas dos vistas diferentes, desde posiciones de cámara distintas, que el cerebro pueda interpretar la diferencia de paralaje y percibir la profundidad. Es el mecanismo básico de la estereoscopía. Pero lo cierto es que lo de “renderizarlas de manera independiente” cada vez aplica menos. Por ejemplo, la arquitectura Pascal de NVIDIA ya permite hacer una sola pasada de geometría para los dos “viewport” de los ojos, ahorrando repetir ese trabajo. Pero la rasterización es inevitable hacerla dos veces: se trata de dos vistas diferentes, con píxeles diferentes.

El tema de la distancia interpupilar se debe a una característica óptica de las lentes llamada “pupila de salida”, que es el diámetro del haz de luz que sale de la lente. Si es muy pequeña, los ojos tienen que estar en una posición muy concreta con respecto a la lente para ver a través de ellas, y será necesario un mecanismo que permita ajustar su posición para colocar las pupilas de salida donde se encuentren las pupilas del usuario. Si la lente tiene pupilas de salida muy grandes, se podrá ver a través de ellas desde un rango mayor de posiciones, y no será necesario ese mecanismo de ajuste.

¿Por qué los cascos de perfil alto, tipo VIVE, deben estar permanentemente conectadas? ¿No disponemos aún el hardware adecuado para transmitir todos esos datos vía WiFi, por ejemplo?

Definitivamente no por WiFi, aunque lo cierto es que existe un estándar de transmisión de vídeo inalámbrico, WirelessHD, que soporta transmisión de vídeo hasta 4K por la banda de los 60 GHz. ¿Cuál es entonces el problema? Porque está claro que los cables son un problema de primera magnitud. En mi opinión, hay dos: robustez de la conexión y lag.

Lo de la robustez va a propósito de que es necesaria línea de visión directa entre emisor y receptor: se está transmitiendo en la banda de EHF (Frecuencia extremadamente alta) a tasas de datos de 28 Gbits/s. En un casco en movimiento, esto es una complicación, y hace que el canal de transmisión sea extremadamente poco fiable. Y ya sabemos lo que le ocurre al usuario de VR cuando la imagen empieza a hacer cosas raras. Además, estamos hablando de dos imágenes simultáneas, lo que duplica el ancho de banda necesario y complica aún más las cosas.

En cuanto al lag, esta capa añade otro retardo extra a la imagen, y con VR sabemos que cada milisegundo cuenta. Pero está claro que va a ocurrir en el corto o más bien en el medio plazo. En cinco años yo creo que estará resuelto.

El precio de la vanguardia

¿Es más caro desarrollar para VR que para los métodos habituales, o los motores tipo Unreal Engine o UnityVR están lo suficiente preparados para que la curva de aprendizaje del estudio sea mínima y el impacto económico poco apreciable?

Es algo más caro, porque es un formato nuevo, hay más experimentación, más prueba y error, más tiempo hasta que se da con la tecla adecuada, los equipos de trabajo son más costosos, el personal capacitado más escaso y además si hablamos de productos AAA —en videojuegos—, los assets van a ver su coste incrementado. Ahora el usuario va a poder examinar muy de cerca y desde muchos ángulos todos los objetos que componen la escena. Pero lo cierto es que yo no considero que estos costes sean especialmente gravosos, van en línea con una industria que cada cinco años obliga a aumentar significativamente las calidades y complejidades de la producción.

La VR es más cara, aunque por factores de mercado más que por factores tecnológicos

Donde está la trampa no es en el incremento de coste, sino en el del riesgo. El videojuego se puede ver como un producto de inversión: alguien invierte una pasta gansa —en forma de meses o años de su vida, o en forma de dinero de inversores, de un publisher, etc.— y espera un retorno. Como toda inversión, está sujeta a un riesgo y a unas ganancias potenciales. En el caso de la VR, aunque la inversión sea similar, el riesgo y las ganancias potenciales no lo son ni por asomo. Para empezar, el parque de sistemas instalados es irrisorio comparado con el de equipos de juego convencional, por lo que el número máximo de compradores, nuestro máximo de ganancias potenciales, es muy inferior. Y el riesgo también es muy alto: si tienes un mercado más pequeño, es más difícil que si tu producto no tiene un éxito muy grande llegues a tener ingresos significativos que te permitan, por lo menos, recuperar lo invertido. En un mercado de1.400 millones de jugadores, el juego 500 de los más vendidos puede estar llegando a unas decenas de miles de personas. En un mercado de un millón, si no estás entre los 10 más vendidos, probablemente estés perdiendo dinero a manta. Así que sí, podríamos decir que la VR es más cara, aunque por factores de mercado más que por factores tecnológicos.

Precisamente por esto, existe mucho debate sobre si las consolas, por ser una versión cerrada y económica de una súper torre de control, “pueden” o no con la VR: ¿es tan agresivo como lo pintan, realmente necesitamos un equipo puntero de 2.000 euros para mover la VR? ¿Depende del tipo de producto y sus exigencias a nivel interno?

Es evidente que cuanta mayor potencia, mayor fluidez y realismo, pero lo cierto es que PS4 ha demostrado que es capaz de mover experiencias VR muy decentes y, sobre todo, va a democratizar el formato, porque no hay mucha gente que tenga acceso a un Vive o un Oculus y un PC VR. Y en todo caso, los desarrolladores van a tardar en sacar el partido a lo que un PC moderno con una gráfica 1080 y procesador a juego puede hacer.

Al final es sencillo de ver: Samsung Gear VR ofrece experiencias VR bastante pasables, y estamos hablando de GPUs un orden de magnitud por debajo de lo que montan las consolas actuales y los PCs de la pasada generación.

¿Por qué cuando se adaptan algunos juegos tradicionales se ven los píxeles o espacios entre ellos dentro de las gafas de RV? ¿Es una cuestión de tamaño de texturas?

Aquí no debemos confundir el píxel físico de las gafas con el “texel”, el pixel de textura. Una textura de resolución pobre lo que provocará, cuando nos acercamos mucho, es superficies poco definidas, como “borrosas”. Aunque lo cierto es que en estas superficies “borrosas” o en superficies de color liso es más fácil distinguir los píxeles de la pantalla “a ojo”. Una imagen compleja, con muchos elementos, va a mantener los píxeles en cambio constante, y va a hacer más difícil “verlos”. Por el contrario, un fondo blanco liso maximiza ese efecto, lo hace terriblemente evidente. Es decir, cuanto menos nivel de detalle fino tenga una textura, más fácil va ser que “se vea el cartón” al display del visor.

soñando en realidad aumentada

Sobre todo el del cardboard. Por cierto, sabiendo que cualquier móvil es un reproductor RV en potencia y viendo su enfoque hacia juegos de Realidad Aumentada: ¿qué diferencias principales existen entre la RV y la RA? En los dos se mapean habitaciones enteras y se simulan acciones, físicas, scripting, shaders… etc.

Son ahora mismo los dos grandes campos en ebullición. La diferencia principal es que la VR es “alienante”. Te extrae y te aísla de tu entorno, tiene una mayor barrera de entrada. Es más difícil imaginar al trabajador del mañana con un casco que le aísla de su entorno. La AR, por su parte, no corta ese contacto con el mundo que nos rodea.

De todos modos, aquí voy a ser tajante: se está vendiendo como AR cosas que no lo son. Pokemon Go no es realidad aumentada: son objetos 3D pintados sobre la imagen que nos trae la cámara y sincronizados con el movimiento del dispositivo. La realidad aumentada lee el mundo que nos rodea y se integra con él, nos aporta capas de datos o incluso lo modifica.

‘Pokemon Go’ no es realidad aumentada: son objetos 3D pintados sobre la imagen que nos trae la cámara y sincronizados con el movimiento del dispositivo

La VR sólo se preocupa de mostrar su mundo. La AR tiene que ser consciente del mundo que nos rodea, de su estructura física, para permitirnos interactuar con él: Si tiro una pelota “virtual” en una aplicación AR, el sistema tiene que integrar el objeto virtual en un modelo tridimensional del entorno que nos rodea, tiene que botar en la mesa que tenemos delante, detenerse cuando se encuentre la pared, o desaparecer de la vista del usuario si se cae detrás de la mesa, por lo menos hasta que ruede de nuevo a una posición en la que la mesa —ni ningún otro objeto— la tape. Eso es AR de verdad, y añade tres complejidades al mundo de la VR:

- Hay que escanear el mundo exterior y mantener actualizado ese modelo en tiempo real con los movimientos del usuario.

- Hay que presentar al usuario las imágenes virtuales generadas por ordenador sobre la imagen que está recibiendo del mundo real, que percibe sin mediación de ninguna pantalla —en caso contrario lo llamaríamos Realidad Mixta—. Aquí no hay lentes que valgan, y se usan ópticas holográficas o difractivas, lo cual, por cierto, es la causa de que las soluciones existentes tengan FOVs (campos de visión) tan pobres.

- Hay que gestionar la interacción del modelo del mundo físico que me proporcionan los sensores con mis elementos del mundo virtual. Una pantalla virtual no puede flotar “dentro” de una pared real, porque rompería totalmente la inmersión.

Por lo demás, la tecnología de simulación física y de generación de gráficos puede ser la misma. Al final, la VR va a converger con la AR y nos permitirá “ser conscientes” del mundo que nos rodea hasta cierto punto, aunque sólo sea para evitar tropezar con el gato. El modo “chaperone” de VIVE es sólo una versión primitiva de ese futuro.

La AR Transformará nuestra relación con la tecnología, la hará más ubicua, más útil y a la vez, más transparente

Para terminar y ya que citamos la RA, según tu criterio, ¿son distintos caminos, uno tiene más posibilidades que otro, se decanta el futuro hacia alguno de ellos? Según la serie Black Mirror, la AR copará todos los espacios sociales.

Sin ninguna duda, la reina será la AR. La VR puede llegar a ser extremadamente popular como herramienta de entretenimiento y formación, pero la AR se convertirá en algo con lo que interactuemos de manera continua y habitual. Transformará nuestra relación con la tecnología, la hará más ubicua, más útil y a la vez, más transparente.

En Nobbot | Realidad virtual + realidad aumentada = realidad mixta