¿Alguna vez te has preguntado por qué tu robot aspirador evita los objetos o cómo ve un coche autónomo? La visión computerizada es un proceso complejo que todavía está haciendo sus pinitos. Por ello algunos aspiradores se chocan contra los muebles y, por desgracia, se producen accidentes en los coches autónomos.

¿Alguna vez te has preguntado por qué tu robot aspirador evita los objetos o cómo ve un coche autónomo? La visión computerizada es un proceso complejo que todavía está haciendo sus pinitos. Por ello algunos aspiradores se chocan contra los muebles y, por desgracia, se producen accidentes en los coches autónomos.

Como la visión humana, la de las máquinas requiere varios elementos: periféricos (ojos), cables (nervios) y procesador (cerebro). Es en este último donde los últimos desarrollos están dando lugar a procesos nunca vistos. Hoy hablamos de cómo las máquinas aprenden a ver.

La inteligencia de Google ya es capaz de ver una imagen

¿Sabías que tu cerebro ha evolucionado para reconocer patrones? Cuando mira cualquier imagen, puede clasificar la información de una manera que las máquinas todavía no son capaces. Si observamos un paisaje rápidamente, identificamos qué es cielo, qué es montaña, qué está verde planta y qué gris piedra. Si miramos un rostro, sabemos decir el género y promediar la edad, e incluso podemos atrevernos con su atractivo.

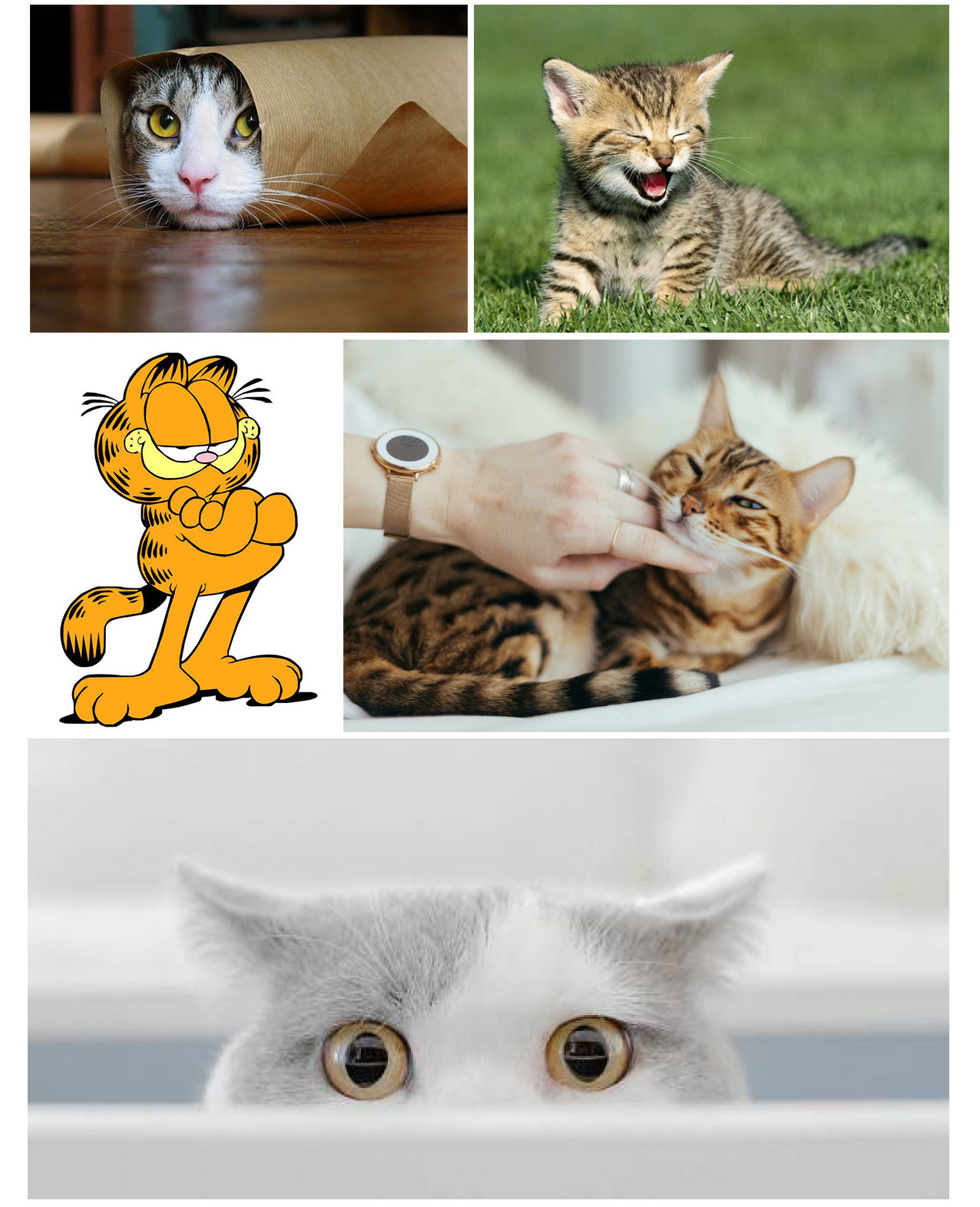

A día de hoy, los robots están aprendiendo a comprender algunas propiedades que para nosotros son triviales. Por ejemplo, ya distinguen contornos, formas, diferencias de colores y rasgos básicos. Si buscas “gato” en Google, te mostrará imágenes muy diversas de gatos, algunas con nombres raros como “IMG_8976”. ¿Cómo sabe el buscador que lo que hay en esa imagen es un gato?

Algunas ni siquiera son gatos reales, como Garfield. Otros carecen de elementos gatunos como el rollito de gato de arriba (sin orejas) y el gato ninja de abajo (sin nariz y boca). Elena González-Blanco, investigadora en Harvard University y experta en inteligencia artificial, ha comentado en varias ocasiones que hay más imágenes de gatos en internet que de ningún otro animal u objeto.

Machine learning y deep learning para reconocer patrones

Que la humanidad esté obsesionada por los gatos es muy útil. Gracias a ello podemos enseñar a las máquinas a diferenciar lo que es un gato de lo que no lo es mediante machine learning y deep learning. En la conferencia ‘Conversaciones 4.0: El impacto de la Inteligencia Artificial en el ser humano y la sociedad’, González-Blanco diferenció estos dos procesos:

“El machine learning aparece cuando a la máquina se le dan una serie de datos con una serie de reglas y la máquina es capaz de aprender a base de ese entrenamiento y generar una serie de inferencias a base de esos datos que se le van dando. ¿Cuál es el caso extremo? El deep learning es una parte del machine learning en que solamente se le dan datos a la máquina (gran cantidad de datos) y la máquina es capaz de extraer patrones y de aprender sola.”

Para el caso de los gatitos, podemos poner dos ejemplos de cómo funciona un buscador de internet:

- Machine learning. Se le da a un algoritmo varios miles de imágenes de gatos y se le dice “esto es un gato” en cada una de ellas. Así aprende que los ojos de gato, las orejas de gato y los bigotes de gato son partes de un gato. Y que cuando alguien busca “gato” en internet tiene que mostrar imágenes con alguno de estos elementos.

- Deep learning. Se le da acceso al algoritmo a millones o miles de millones de datos sobre búsquedas previas de gatos, así como aquellas que resultaron fructíferas. La máquina, por sí misma y a través de una red neuronal, aprende que cuando la gente busca “gato” quiere ver imágenes en las que aparecen una serie de elementos. Y se los muestra.

Esto tiene un sinfín de usos. Desde buscar gente parecida a ti en internet mediante búsqueda inversa, a ayudar a los robots a no chocarse. Pero también a rescatar gente, cultivar, medir el CO2 o localizar pateras.

Algunos usos de la visión de las máquinas

A muchos kilómetros sobre nuestras cabezas, un gigantesco ojo observa la Tierra y a sus habitantes. Es el OCO-2 (Orbiting Carbon Observatory 2) lanzado en 2014 por la NASA. La revista ‘Science’ lo llamó “ojo en el cielo”. Hace tiempo que nos dimos cuenta de que los mismos satélites con que miramos el cosmos podrían darnos datos sobre el planeta, así que lanzamos el OCO-2 para ver el CO2.

La cámara del OCO-2 funciona en una frecuencia diferente a la del ojo humano, de modo que puede ver los componentes atmosféricos. Después de meses de datos y hacer fotos, los investigadores le dijeron “esto es CO2” (machine learning). Ahora nos avisa en tiempo real de la contaminación y nos permite hacer nuevas predicciones.

Otro ejemplo de cámara con un rango distinto al ojo humano es la cámara térmica. Durante la búsqueda de Gabriel Cruz, varios voluntarios pilotos de drones acudieron a la llamada de los padres. Usaron cámaras térmicas para buscar puntos de calor por la noche.

Esta misma tecnología la emplea la Guardia Civil desde 2007 para la vigilancia costera, y los bomberos para localizar puntos calientes. Los drones están llevando al límite esta capacidad, fusionando estas imágenes con sistemas de reconocimientos de patrones.

En unas décadas los drones de salvamento en montaña podrán llevar incorporados ojos para buscar desaparecidos. En lugar de tres operarios por cámara (piloto, asistente de cámara y observador), tendremos decenas de drones autónomos buscando. Pero para eso hemos de enseñarles antes a ver. Y en esas estamos.

Esto ya es una realidad en varios sectores, como el vinícola o la conservación de especies:

- Las bodegas Martín Codax (Rías Baixas) llevan años experimentando con drones autónomos y sistemas de aprendizaje automático para controlar sus viñedos.

- En Santa Cruz de Tenerife, astrofísicos y ecólogos se han unido para usar aviones no tripulados y localizar animales usando “software libre de detección de fuentes astronómicas”.

Hay más casos, pero en todos el estado del arte es similar. Todavía estamos en la fase de obtener datos para el machine learning, y muy lejos de un deep learning. Sin embargo, los datos crecen de manera exponencial, así como la potencia de cálculo. En breve tendremos los primeros sistemas de visión 100% autónomos.

Los vehículos autónomos están a la vuelta de la esquina, justo tras los coches conectados. Serán la próxima gran generación de máquinas que vean. Con varias particularidades. No solo usarán cámaras como ojos, sino también radares (como los murciélagos y delfines), cámaras térmicas (algunas serpientes) o láseres LiDAR.

Además, contarán con nervios ópticos de varios tipos, cables y redes inalámbricas; y varios cerebros, uno local para tomar decisiones rápidas y uno en la nube dependiente de la baja latencia del 5G para organizar el tráfico. Nuestra generación verá la primera generación de máquinas que vea.

En Nobbot | ¿Cómo aprenden y aprenderán los robots?

Imágenes | iStock/peshkov, Google Imágenes, iStock/sezer66