Imagina por un momento que alguien se traga todo el conocimiento de internet. Todo: desde la Wikipedia y la Common Crawl hasta viejos blogs de poemas. Y tras devorar estos 5.630 millones de webs —unos 45 zettabytes de nada— comienza una conversación contigo. Esta persona se llama GPT-3.

GPT-3 son las siglas de Generative Pre-Trained Transformer 3, un modelo de lenguaje desarrollado por OpenAI, el archiconocido laboratorio y organización sin ánimo de lucro fundada en San Francisco (Estados Unidos) por Elon Musk, entre otros. Una empresa donde Microsoft ha invertido nada menos que 1.000 millones de dólares.

“Cuanto más leas, más cosas sabrás. Cuanto más sepas, más lejos llegarás”. Esta cita del popular Theodor Seuss Geisel (‘Dr. Seuss’ para los amigos), podría resumir a la perfección la actitud de GPT-3. Y la herramienta es abrumadoramente hábil, capaz de codificar órdenes sencillas, aunque sus creadores piden mesura a la hora de ilusionarse: al fin y al cabo, esta inteligencia artificial (IA) puede leerlo todo y no entender nada.

GPT-3 NO ENTIENDE NADA

Debemos pararnos un momento en la anterior afirmación. GPT-3, como da a entender su apodo, es la tercera iteración de un modelo de machine learning que no ha dejado de evolucionar. La algoritmia de GPT2 contaba con muchos menos parámetros —1.500 millones, frente a los actuales 175.000 millones— y ya era sorprendentemente hábil. No pensemos aún en Skynet y la consciencia emancipadora.

Basándose en aplicaciones de procesamiento natural del lenguaje (PNL), GPT-3 ha demostrado cierta competencia para construir relatos de terror, poemas, cuentos eróticos, propaganda militar y hasta como generador de noticias. Por cierto, tiene su propio podcast.

Pero, como apuntan en este artículo, «la coincidencia estadística de palabras no sustituye a una comprensión coherente del mundo». Es decir, GPT-3 no sabe lo que lee. Ni una letra. Aún queda bastante para que este código genere lenguaje, que no palabras. Su inteligencia se basa en la acumulación de patrones. Y a veces entiende que lo más resolutivo es replicar una respuesta arcaica en vez de generar una nueva combinación. Algunos encontrarán esta pereza un gesto de verdadera inteligencia.

Uno de los ejemplos más populares de su fallida comprensión puede encontrarse aquí, donde GPT-3 es sometido a distintos test de Turing y en la gran mayoría responde sinsentidos que serían impropios de cualquier humano, como decir que un pie tiene dos ojos o incluso soltando con impunidad mentiras como que los New York Yankees ganaron el World Series en 2023. ¿También predice el futuro?

Al fin y al cabo, su operatividad no difiere de otras IA: los sistemas de reconocimiento facial identifican a las personas a través de un vasto banco de imágenes. El entrenamiento refina el resultado. Ya no hablamos de los distintos niveles semánticos, del significante y significado de cada palabra dentro de cada contexto particular. Una IA que, en resumen, alberga un gran potencial, una capacidad estratégica enorme.

ANÁLISIS VISUAL FRENTE A ANÁLISIS CONTEXTUAL

Esta falta de comprensión no limita su operatividad. Porque ahora viene lo mejor: genera código al vuelo y puede convertirse en la herramienta favorita de los desarrolladores del futuro.

El cambio de paradigma lo presenta su versatilidad: si damos una descripción del código que queremos generar en Python, el modelo es capaz de programar en Python sin haberle enseñado específicamente esta función. Es de locos, en ningún momento se le ha especificado que esta es su tarea, que así debe hacerlo y no de otra forma. Si le preguntamos sobre cualquier secuencia, GPT-3 la completa. Esta es su forma de pensar: nunca se queda sin respuesta, siempre aporta una solución, fallida o no.

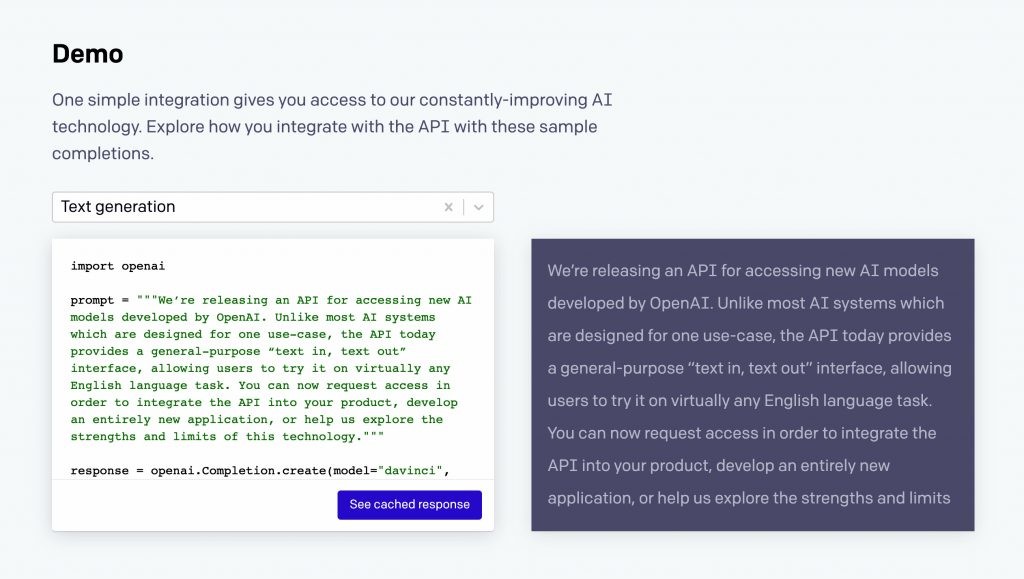

La API es tan intuitiva como interactuar con un cajón de texto y su capacidad tan voluble como la creatividad del programador. Esta es la clave del natural language processing: podemos condicionar la respuesta, echarle una mano como hacemos cuando un niño se queda en blanco buscando una respuesta coherente a una pregunta que no entiende.

El sistema ha aprendido a traducir contrastando otros párrafos traducidos en Internet y los resultados son tan buenos como los de Deepl, el considerado mejor (auto)traductor del mundo. Entonces, ¿qué le falta? Pensar en imágenes.

Un viejo artículo del literato Cormac McCarty incidía en nuestra capacidad de entender y comunicarnos con imágenes a través de símbolos traducidos por el subconsciente. De nuestros varios millones de años de historia, según el consenso, apenas hemos usado el lenguaje durante los trescientos mil años. Hemos aprendido, por tanto, el significado de las ‘cosas’ antes siquiera de adjudicarles nombre. El complejo lenguaje de GPT-3 ha de bregar con esta realidad: código es y solo código es capaz de ver.

SESGO COGNITIVO SIN COGNICIÓN

Tampoco olvidemos que internet está claramente sesgado y ofrece una representación no veraz del mundo. Esta IA no cuenta con ningún corpus moral interno, así que es capaz de despertar el odio a través de mensajes antisemitas o misóginos devorados de miles de webs culturalmente oscuras.

Ha leído millones de afirmaciones sobre política, religión o raza, así que siempre podrá dar una opinión que, por desgracia, no deja de ser la suma regurgitada de opiniones ajenas. Su club favorito solo será la suma estadística de un club de éxito citado miles de veces. Sin voz propia, ¿qué nos queda? Todo lo demás.

Tal vez GPT-3 enfrente problemas de oratoria despierta pero supone un cambio increíble en la forma en la que interactuamos con lenguajes de programación. Redacta tablaturas de guitarra a través de archivos de texto ASCII, lo que significa que es capaz de componer música a partir de unas directrices mínimas. Puede responder una consulta médica, autocompletar imágenes —ideal para fotos borrosas, antiguas o dañadas—, crear sus propios motores de búsqueda o generarte un currículum. Sus resultados eran impensables hacen tan solo un lustro. Imagina lo que podrá ofrecernos un GPT-10.

Falta mucho, tal y como bromeaba el investigador de IA Geoffrey Hinton, aunque cuesta imaginar los actuales límites de GPT-3. Tal vez no existan respuestas erróneas, sino preguntas incorrectas.

En Nobbot | Inteligencia artificial para convertir tus monigotes en fotos realistas