Últimamente se habla mucho de Inteligencia Artificial. No cesan los titulares copados de frases ampulosas donde el robot más tonto parece a punto de destruir el mundo. Y, a poco que ese robot sea inteligente, es seguro que, antes de destruir nada, se replantearía conquistarlo.

Si el pasado mes de marzo nos encontramos con Tay, un bot con “zero frío” y capaz de interactuar de forma dinámica y adaptativa, el cual acabó convertido en un juguete racista y machista, recientemente hemos sabido de una IA capaz de reconocer, en una conversación, un número parejo de palabras a las que reconocería un ser humano: una tasa de error de apenas un 5,9% en texto dictado.

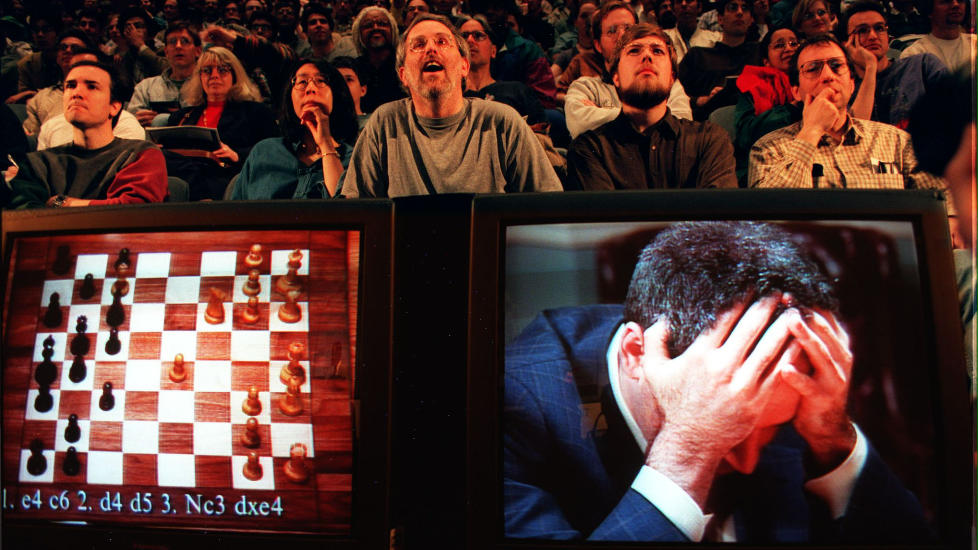

Y aún podríamos remontarnos hasta los primeros hitos, a Chinook ganando a las Damas en 1994 o Deep Blue ganando a Gary Kasparov en 1997. Pero partamos de otro punto de origen: lo primero que debe quedarnos claro es que no todas las IA son iguales. Existen divergencias: Deep Blue era un superordenador y, como tal, su velocidad de computación para predecir jugadas en un futuro inmediato era superior a la capacidad de Kasparov, que sólo atendía a su experiencia y su intuición. Tay, igual que Siri o Cortana, son bots que analizan el lenguaje y aportan respuestas más o menos coherentes. Ambos, en líneas generales, son sistemas expertos, que infieren soluciones en base a las reglas escritas. Es decir: realizan búsquedas heurísticas.

PROFUNDIZANDO EN LA RED

La Inteligencia Artificial vivió un duro invierno de casi 30 años. Aquel estancamiento se debió a fracasos en las investigaciones que no arrojaron ningún enfoque concreto. El ser humano, aún sin conocer muy bien cómo funciona el cerebro humano, apostó por crear funciones simuladas. «Un callejón sin salida», decía Jason Pontin, portavoz de avances tecnológicos para el MIT. Hasta que empezaron a pensar desde la perspectiva de la máquina, no del humano. La IA que resuena en nuestras cabezas es otra cosa, un constructo alejado de las inteligencias simbólico-deductivas comunes, más elástica y en posesión de un pensamiento tangencial, que no atienda sólo a redes bayesianas —a algoritmos de probabilidad, para ser exactos—. Algo similar a lo que ofrece Deep Mind.

«Cuando diseñamos DNC, queríamos máquinas capaces de aprender a navegar y formar estructuras complejas de datos por su cuenta. En el corazón de un DNC hay una red neural llamada controlador, responsable de tomar la entrada, leer y escribir en la memoria, y producir lo que puede ser interpretado como respuesta». Estas eran palabras de los principales investigadores implicados en Deep Mind.

Aquí tenemos el primer concepto al que asirnos: redes neuronales. Este es el verdadero paso adelante. Ya no se trata de una gestión inteligente de información, una efectividad de recursos o simple músculo, como el que Deep Mind demostró calculando miles de variables de cada movimiento de aquella histórica partida de ajedrez.

NO ES LO MISMO PENSAR COMO UN HUMANO QUE ACTUAR COMO UN HUMANO

Si pensamos en la IA en términos lógicos, podemos decir que desde hace tres décadas ya tenemos sistemas perfectos —desde que nos superó en capacidad de cálculo, en bruto, la primera granja de ordenadores conectados pensando de manera conjunta—. Al fin y al cabo, la lógica impone los razonamientos, el comportamiento más habitual. Por eso podemos crear IAs que ganen en todos los videojuegos de Atari, por ejemplo, como lo que ha logrado DQN (Deep Q-Networks).

Pero la mente humana es caótica, incoherente por momentos. Actuar como un humano significa algo más que «resolución de problemas sobre un marco teórico seguro». No se trata de resolver silogismos, sino de penetrar en los recovecos del aprendizaje. No pocas veces la opción lógica, la más segura, implica nuestro perjuicio. Y el riesgo, la no imitación de cánones, un éxito inesperado. Esto es lo que mide ocasionalmente el small data.

Para este particular se han creado las redes neuronales artificiales, sistemas con diferentes “capas” de profundidad que tratan de emular el pensamiento mediante aprendizaje. Un sistema evolutivo. Que Cepheus, una IA desarrollada por la Universidad de Alberta (Canadá) sea el mejor jugador de póker del mundo o que Watson haga lo propio vapuleando a sus rivales en Jeopardy! es sólo la punta del iceberg.

Watson ha demostrado una gran capacidad cognitiva. Lo “disfrazaron” para participar en un programa de cocina, donde la creatividad y el pensamiento lateral es clave, no la mera combinación de sabores y texturas. Watson pasó a ser un joven ucraniano de nombre Eugene Goostman. Y logró engañar a los jurados, hasta ganar. Florian Pinel, coordinador del equipo de investigadores que trabajan con Watson lo resumía así: «Para elaborar un plato hay trillones de combinaciones posibles. Watson las procesa y sólo escoge las más interesantes».

UN LARGO CAMINO POR RECORRER

Evidentemente, no es oro todo lo que reluce. Watson generaba una ruta de trabajo, no presentaba sobre la mesa el plato terminado. Eran los cocineros profesionales, con sus manos expertas, los que llevaban a cabo el experimento, siguiendo paso a paso la pauta del ordenador, pero aplicando su capacidad de trabajo y, en fin, inyectando un poco de cada uno. Porque ya se sabe lo que dicen con la comida: hasta tu estado emocional afecta al sabor final del plato.

Demis Hassabis, investigador de IA y neurocientífico, creó AlphaGo hace un año, desde los laboratorios de Google DeepMind. ‘Go’ es un juego que ha sufrido diferentes reformulaciones pero, en esencia, es el mismo que nació hace 2.500 años. Practicado por más de 40 millones de personas, este juego deja en ridículo por cantidad de variables al ajedrez. Es decir, para ganar hay que pensar como pensaría una persona. Y AlphaGo ha ganado a todos los contrincantes-persona que ha tenido delante.

AlphaGo va aún un paso más allá al usar redes profundas. Esto redunda en lo siguiente: tal vez la primera respuesta sea consecuente con la inercia del reglamento. Pero sus siguientes respuestas se basarán en la experiencia previa. Como cualquier ciudadano de a pie, a más experiencias, mayor conocimiento. ¿Necesitan las IAs, entonces, un dilatado periodo de aprendizaje para lograr su “forma final”? Las pruebas de pilotaje automático en Tesla dicen que sí, por citar un ejemplo popular.

Ahora que comprendemos la estructura básica de pensamiento de una máquina, ahora que sabemos cómo hacer que aprenda de observar, es hora de darle libre albedrío. Los primeros experimentos han sido caóticos. Sólo hay que fijarse en la citada Tay. Crearemos niños respondones, malcriados, caprichosos. Hasta que atravesemos esta adolescencia de conocimiento mal adquirido, de líneas rojas y accidentes programáticos, para lograr una madurez en cuanto a la cognición del software.

La meta final de una buena IA es que pueda ejecutarse de manera independiente —no de una máquina, sino del autor/padre que le impulse a volar— y que sea capaz de adaptarse a las situaciones más incómodas. Por ejemplo, un ser humano puede escuchar una palabra, pero interpretarla de muchas formas en base a la inflexión y tono del interlocutor. La inteligencia es algo más que ceros y unos. O eso queremos creer, por miedo a que la teoría nos sea invalidada.

Imágenes | Tay (Microsoft) | Wikipedia | Google DeepMind

En Nobbot | El continuo interés por la Inteligencia Artificial