Un equipo internacional liderado por investigadores de la Universidad de Jaén ha diseñado un sistema no invasivo que emplea los pensamientos para interactuar con un hogar inteligente.

El grupo Sistemas Inteligentes Basados en Análisis de Decisión Difuso (SINBAD²) de la Universidad de Jaén, junto con las universidades de Ingeniería y Tecnología, Lima – UTEC (Perú) Essex (Reino Unido) y Nantong (China) ha desarrollado un sistema más preciso que lee señales cerebrales para que personas afectadas por ictus puedan interaccionar con un hogar inteligente.

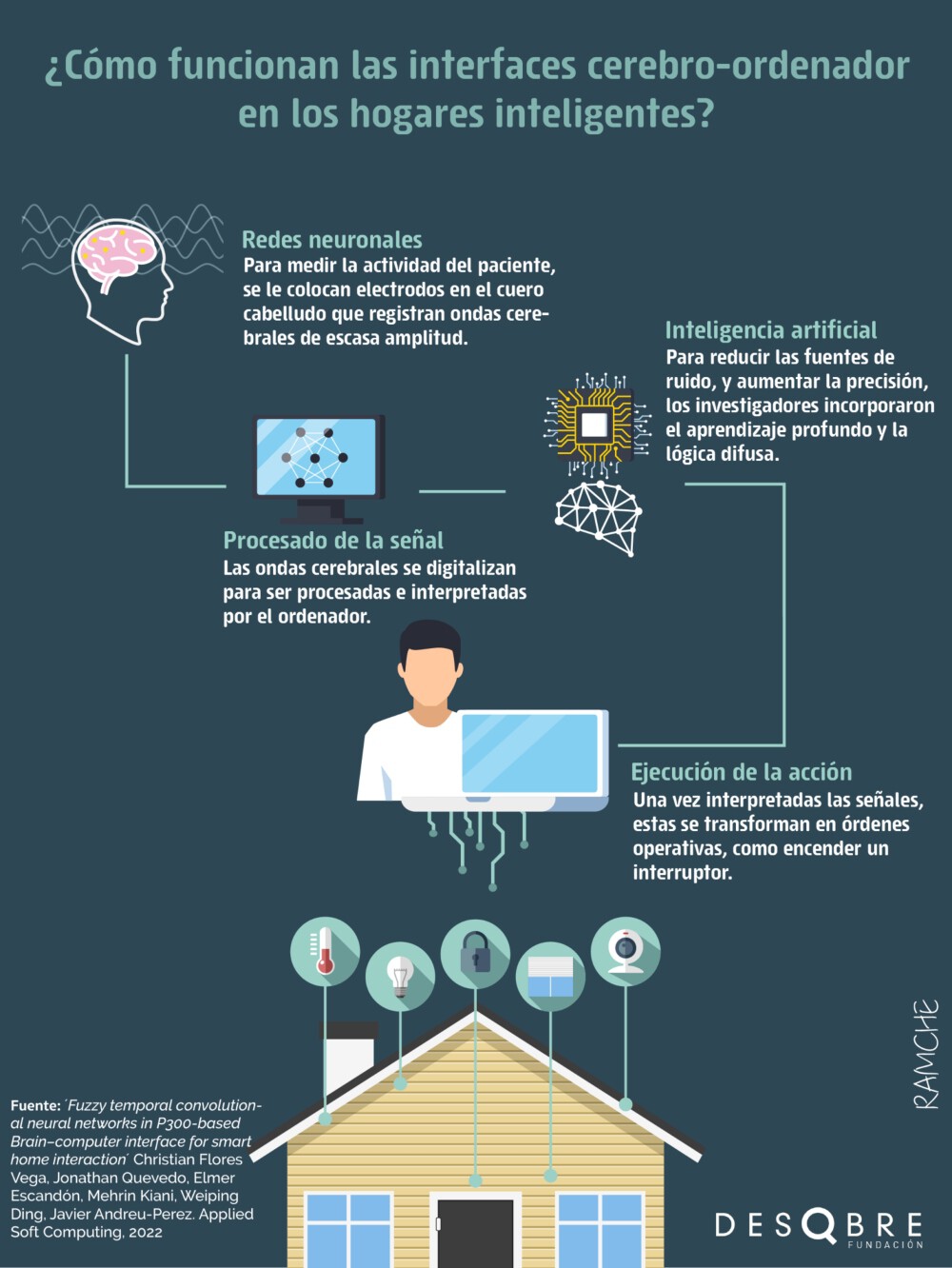

La novedad del modelo es que combina el electroencefalograma no invasivo, es decir, capta las ondas de un casco con electrodos que se coloca en la cabeza del paciente, sin necesidad de ningún tipo de cirugía, con arquitecturas de inteligencia artificial para el procesamiento de la señal. De esta forma, alcanza una efectividad en la decodificación que roza en algunos casos 100% en un entorno natural, es decir, fuera de un contexto controlado, como un laboratorio de neurociencia.

El modelo, publicado en el artículo Fuzzy temporal convolutional neural networks in P300-based Brain–computer interface for smart home interaction de la revista Applied Soft Computing se probó con experimentos en seis sujetos sanos y tres que habían sufrido un accidente cerebrovascular. Los investigadores partieron de las señales de un encefalograma, es decir, a todos los participantes se les colocó un casco con electrodos para medir las señales cerebrales.

Esta estrategia no resulta invasiva para el usuario, pero al aplicarse al cuero cabelludo introduce muchas interferencias o ruido en la señal. A lo que se le suma el sonido no deseado del ambiente.

lógica difusa en el hogar inteligente

Para reducir estas fuentes de ruido y aumentar la precisión del modelo, los investigadores incorporaron dos arquitecturas basadas en inteligencia artificial: el aprendizaje profundo y la lógica difusa. El primero imita las características estructurales del sistema nervioso humano, donde existen áreas del cerebro especializadas en tareas como el lenguaje o el reconocimiento facial. En este caso, la máquina permite aprender mediante redes neuronales especializadas en la detección de ciertas características ocultas de los datos.

Sin embargo, estas redes neuronales son muy sensibles al ruido, tanto de las interferencias del propio casco aplicado al cuero cabelludo, como del ambiente. Por ello, los investigadores añadieron aprendizaje difuso. “Se trata de unas funciones que ayudan a la red neuronal a aprender de estos patrones, pero modelando la incertitud. Así, aunque haya ruido, la red neuronal lo omite”, detalla el investigador de la Universidad de Jaén, Javier Andreu-Perez, autor correspondiente del estudio.

La combinación de estas técnicas aumenta la fiabilidad del sistema para decodificar este tipo de estímulos cerebrales para alcanzar una precisión del 98,6%. “Hasta ahora, no se habían integrado interfaces cerebro-máquina, aprendizaje profundo y lógica difusa. Por eso, nuestra estructura combinada mejora los resultados obtenidos hasta el momento”, subraya Andreu-Perez.

Esta precisión convierte al modelo en candidato para aplicaciones donde se puede usar el cerebro como medio de comunicación con la máquina mediante pensamientos en entornos naturales. Es el caso de herramientas para ayudar a personas con movilidad reducida donde con sólo pensar en una orden, se movería un dispositivo en su hogar. “También para la industria del entretenimiento y los juegos, así como la neuro-rehabilitación remota desde casa”, adelanta el autor del estudio.