En la serie Philip K. Dick’s Electric Dreams (2017), antología de ciencia ficción distribuida por Prime Video, aparece la Autofac, una factoría autónoma con la misión de fabricar y repartir todo aquello que los humanos pudiesen necesitar, destrozando a su paso el medio ambiente en un evidente guiño a cómo los sistemas de reparto mundiales (Amazon, Alibaba) hacen un uso intensivo de materiales y combustibles.

El gran problema con la Autofac dista mucho de consideraciones modernas como el paro o el trabajo remunerado eliminado por robots; y tiene más que ver con que no se detenga nunca, y que la polución ambiental o la destrucción de especies no sea un motivo para frenar su actividad. Carece de programación ética y por tanto “ella” sigue fabricando incansable, e incluso mete presión a los humanos para que necesiten nuevos bienes. Si ellos no necesitan, ella pierde su función, por lo que su cometido pasa a generar dependencia.

Por supuesto, estamos muy lejos de una autofactoría que piense por sí misma, pero no estamos lejos de otras tecnologías autónomas que necesitan urgentemente tanto ingenieros como filósofos y sociólogos. Todas las ramas son necesarias cuando nos damos cuenta de que los niños pasan horas hablando con Alexa y Siri, inteligencias con cierto grado de autonomía, pero dependientes de los programadores de Amazon o Apple respectivamente.

Ética en acción, la iniciativa del IEEE

El IEEE se autodefine como «La organización técnica profesional más grande para el avance de la tecnología», y sin duda son bastante grandes. Surgieron de la empresa The Institute of Electrical and Electronics Engineers, Inc, pero hace años que se dieron cuenta de que la tecnología necesita cierto blindaje ético, moral y social del que carecían. Empezaron a buscar socios, y ahora son un importante lobby tecnológico con la misión de hacer mejor la tecnología e impulsar su desarrollo.

La iniciativa Ética en acción del IEEE tiene su base en cómo de importante es que diseñemos la ética de las máquinas, especialmente cuando nos orientamos a los sistemas autónomos inteligentes (IAS), ni siquiera a las inteligencias artificiales. La diferencia entre ambos es que la IA clásica se parece más a la mentalidad humana, y los IAS no tienen por qué llegar tan lejos para funcionar.

- IA: un chat que parezca entenderte y que pase el Test de Turing.

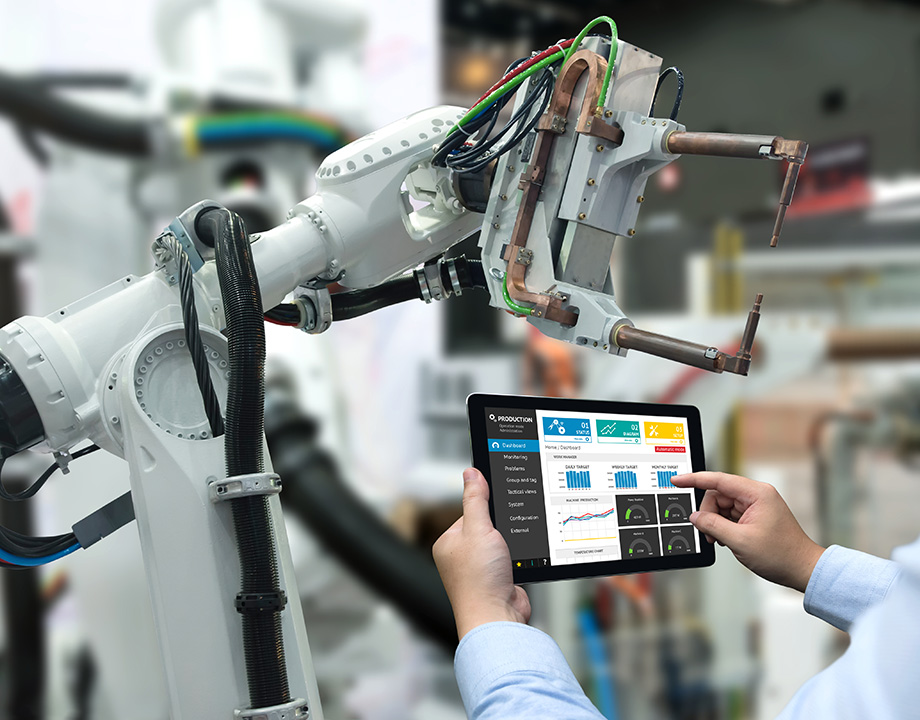

- IAS: el control fino de un brazo robótico inteligente.

Según Raja Chatila, presidente del comité ejecutivo de IEEE, es necesario que el diseño de las máquinas esté alineado a nuestros valores morales y principios éticos, con objeto de que cualquier inteligencia fruto de la tecnología mantenga una serie de principios básicos (supuestamente) como los seres humanos.

El documento consolidado Ethically Aligned Design – Version 2 (Un Diseño éticamente alineado, bajo licencia CC BY-NC 3.0 US) contiene 100 puntos clave sobre los pasos que consideran correctos en la investigación de IA y otros sistemas autónomos. Se parece bastante a los 23 Principios de Asilomar para la IA, algo más resumidos pero también incompletos, que tanto defendía en 2017 Elon Musk, de los que los cinco primeros son:

- El objetivo de la investigación en IA debe ser el de crear una IA no dirigida [autónoma] pero con una inteligencia beneficiosa [para los humanos].

- Las inversiones en IA deberían ir acompañadas de fondos para la investigación que asegure este uso beneficioso, incluídos temas conflictivos como la informática, la economía, el derecho, la ética, los estudios sociales, etc.

- Debería haber cierto intercambio constructivo entre los investigadores de IA y los responsables políticos.

- Se debe fomentar una cultura de cooperación, confianza y transparencia entre los investigadores y desarrolladores de IA.

- Los equipos que desarrollan sistemas de IA deberían cooperar activamente [en lugar de correr por el primer puesto] para evitar carencias en los sistemas de seguridad.

No es de extrañar que estos documentos sean tan densos y estén tan sembrados de minas para el avance, incluso cuando son propuestos por grandes lobbies en busca del avance tecnológico. En la próxima década se espera que los chats conversacionales sean una realidad, así como los vehículos autónomos, y necesitamos construir sobre una base sólida.

Los vehículos autónomos y el dilema del tranvía

Si siempre se termina hablando del dilema del tranvía es porque constituye todo un reto ético para los humanos que podemos extrapolar a la conducción autónoma. El dilema del tranvía dice que un tranvía que no puede ser detenido está a punto de chocar contra cinco personas, y que la única manera de evitarlo es hacer uso de una palanca que lo desviará por una vía en la que hay una persona. ¿Se debe mover esa palanca?

Imaginemos que un vehículo autónomo avanza dentro de la legalidad a 120 km/h por el carril central de una autopista mientras adelanta a un motorista sin casco (a su derecha), y otro motorista con casco le rebasa por el carril de la izquierda. El coche detecta un peligro mortal para el ocupante delante y calcula que frenar no será suficiente: tiene que invadir uno de los dos carriles de los lados para salvar la vida al ocupante. Por supuesto, nos planteamos:

- ¿Debe el coche salvar la vida al ocupante, invadiendo el carril de uno de los dos motoristas, mucho más vulnerables?

- ¿Y si dentro del coche fuesen cuatro bebés recién nacidos? ¿Entonces sí?

- ¿Qué sería más inmoral, que el coche dejase morir a sus ocupantes o que dejase morir a alguien que no está dentro?

- ¿Cambia la decisión si el coche es de alquiler a si el ocupante pagó por él?

- En caso de giro, ¿avanza hacia la izquierda porque el motorista con casco tiene más posibilidades de sobrevivir, o hacia la derecha porque el motorista no sigue las normas de circulación?

Si tiene gira a la izquierda está castigando al motorista que cumplió la ley, al que lo hizo bien, mientras que si gira a la derecha prácticamente condena al que no lo hizo. ¿Tomar una decisión es ético? ¿Es más ético no tomarla? Todos estos problemas éticos son realmente complejos, especialmente si tenemos en cuenta que la mayoría de los humanos darían un volantazo sin reparar en los demás usuarios de la vía.

¿Le pedimos a la IA que tire los dados como hacemos nosotros? Esta opción no parece muy inteligente, pero la alternativa es programar de antemano este tipo de decisiones, o al menos programar una tecnología autónoma que las resuelva en microsegundos.

¿Tenemos los humanos una ética común?

Si toda la humanidad tuviese una ética o unos valores morales idénticos, es probable que estos permeasen a las máquinas a medida que las entrenamos mediante machine learning. Esto no es así, y es el motivo por el que varios chats conversacionales y máquinas han adoptado sesgos racistas, como aquella cámara de HP que no distinguía a las personas de color:

El inconveniente con la cámara HP pudo solucionarse fácilmente entrenando la cámara con personas de color (había sido diseñada por un equipo compuesto solo por asiáticos y literalmente era incapaz de “ver” un tono más oscuro), pero muchas de las máquinas del futuro, como los mencionados vehículos autónomos que ya circulan por las ciudades, necesitan una ética firme sobre la que construir. Una que no se arregle con parches una vez hayan sido lanzados al mercado.

Aunque existen puntos comunes, no existe eso de “una ética” o “una moral”. De hecho, la tecnología parece atomizar las opiniones hasta el punto en que resulta complicado mantenerse en una zona de decisión gris. Para la mayoría de los asuntos éticos, parecemos tener una decisión tajante: sí o no, sin puntos intermedios.

Algunos ejemplos en los que la opinión está muy dividida y parece casi irreconciliable son el ciborguismo, los trabajos con células madre, el sexo con máquinas, la transgenia en medicina y las técnicas CRISPR/Cas9, la gestación subrogada, el uso de transgénicos en alimentación, y un largo etcétera. ¿Sabremos elegir una programación para las máquinas lo suficientemente flexible como para abarcar toda la ética humana?

En Nobbot | iCar, ¿en qué punto está el coche autónomo de Apple?

Imágenes | iStock/cookelma, iStock/Zapp2Photo, iStock/carloscastilla