1ª Ley: Un robot no hará daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

2ª Ley: Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la 1ª Ley.

3ª Ley: Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la 1ª o la 2ª Ley.

(Leyes de la robótica. Isaac Asimov)

Desde que leí estas leyes en un libro de Asimov, siempre me han fascinado y me han parecido un punto de inicio muy interesante para definir problemas éticos y morales, incluso no sólo para la inteligencia artificial, sino, también, para nuestra vida cotidiana. Por ejemplo ¿debe un robot asesinar o dejar que asesinan a una persona si con eso consigue salvar a otras dos? ¿Debe salvar a una persona que supuestamente tiene más valor para la sociedad y dejar morir a otra menos valiosa? (por ejemplo un criminal). Como se puede ver, estas preguntas no sólo afectan a los robots aunque, para ayudarles a ellos, el MIT ha desarrollado una Máquina Moral, sobre la que hablaremos más tarde.

La leyes de la robótica se redactaron hace ya bastante tiempo, en 1940 (interesante que estas leyes éticas surgieran en el contexto histórico de la Segunda Guerra Mundial), y por aquel entonces la Inteligencia Artificial era sólo una idea que estaba en la cabeza de algunos científicos y pensadores. La informática apenas estaba dando sus primeros pasos (Alan Turing había formulado la idea de Máquina de Turing, que es el origen de nuestros ordenadores en 1936).

Pero el tiempo ha pasado veloz y ahora escuchamos los términos inteligencia artificial o «bots» en multitud de noticias, análisis y artículos. Llevamos algún tipo de «bot» en el bolsillo (Siri, por ejemplo), se habla de coches con inteligencia (Tesla y su autopilot), y desarrollos como Watson permiten vislumbrar los primeros sistemas que pueden llamarse inteligentes.

filosofía y computación

filosofía y computación

Siempre surgen la misma pregunta: si algún tipo de inteligencia artificial tiene que tomar una decisión que afecte a personas, ¿cómo debe actuar? Entramos de lleno en la Ética y Moral, una disciplina que, aunque camina con nosotros desde el comienzo de la humanidad, sabemos que nunca llegará a estar completa y resuelta, ya que se va creando a medida que recorremos nuestro camino, tanto a nivel personal como a nivel de especie. Además, para aplicarla a la IA dos mundos aparentemente contradictorios como la Filosofía y la Computación, deben encontrarse y dialogar profundamente.

Fruto de esta necesidad, cada vez más científicos hablan de debates morales en la IA, y se preguntan cómo podemos «enseñar» Ética a las máquinas. Y la respuesta es, como para cualquier sistema inteligente biológico o no, el aprendizaje y la experiencia. Nosotros aprendemos valores éticos a medida que crecemos y nos enfrentamos a situaciones concretas, apoyándonos en lo que nos dicen nuestros seres más cercanos (familia, amigos, comunidad, sociedad, …).

Los griegos ya creaban dilemas éticos para que cada persona pudiera reflexionar y aprender sobre cómo actuar, y filósofos, sociólogos y antropólogos buscan un sustrato general sobre el que se pudiera apoyar una Ética Universal.

dilema del tranvia

Uno de los dilemas más famosos (actualizado a nuestros días, eso sí) es el dilema del tranvía, que podría expresarse en una de sus formas como:

Un tranvía descontrolado se dirige hacia cinco personas. El sujeto se sitúa en un puente sobre la vía y podría detener el paso del tren lanzando un gran peso delante del mismo. Mientras esto sucede, al lado del sujeto sólo se halla un hombre muy gordo; de este modo, la única manera de parar el tren es empujar al hombre gordo desde el puente hacia la vía, acabando con su vida para salvar otras cinco. ¿Qué debe hacer el sujeto?

una máquina moral para ayudar a decidir a los robots

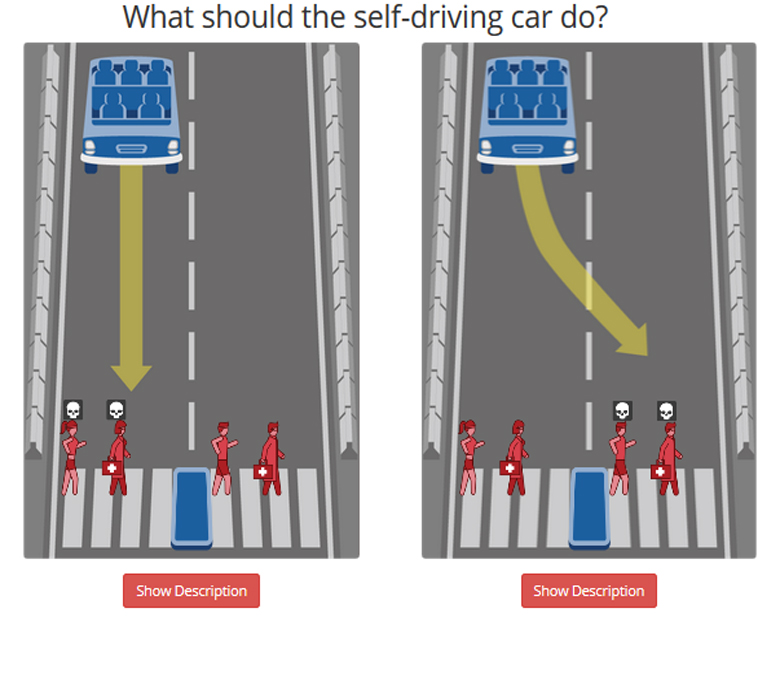

Apoyándose en la misma idea, y aplicándolo al aprendizaje de los sistemas automáticos de conducción (coche inteligente, vamos), el MIT Media Lab ha creado una plataforma (Moral Machine) para enseñar a los coches a decidir en situaciones críticas de vida o muerte, a través de la recolección de respuestas de multitud de personas ante dilemas éticos como los planteados en el dilema del tranvía.

Si accedemos a esta página web, podremos participar en un juego en el que se nos presentan dilemas éticos, y nosotros tenemos que decidir qué haríamos. Además de contestar a esas preguntas, es posible crear escenarios donde aparezcan otras situaciones concretas, y estos escenarios serán presentados a otros jugadores para conocer su respuesta ante los mismos.

Se trata de una iniciativa de colaboración abierta en la que, a partir de multitud de respuestas humanas, podrían inferirse reglas probabilísticas que utilizarían estos sistemas inteligentes para actuar en situaciones críticas. Un buen y creo que acertado comienzo.

Se trata de una iniciativa de colaboración abierta en la que, a partir de multitud de respuestas humanas, podrían inferirse reglas probabilísticas que utilizarían estos sistemas inteligentes para actuar en situaciones críticas. Un buen y creo que acertado comienzo.

Mientras tanto, recomiendo leer los libros de Asimov.