Hace ya casi un año en este mismo medio, en el artículo “Una máquina moral para enseñar a decidir a los robots”, reflexionábamos sobre cómo enseñar a los robots y máquinas inteligentes a tomar decisiones morales. Con la introducción de los “bots”, los coches autónomos, los sistemas de inteligencia artificial, se abre un mundo de posibilidades increíbles que pueden proporcionarnos grandes ventajas en todos los niveles, individual y socialmente.

Ética para los robots

Ya nos preguntábamos por aquel entonces que, si los sistemas inteligentes debían tomar decisiones que afectaban a seres humanos, era necesario “enseñar” ética a las máquinas. Y teniendo en cuenta que no hay una forma normativa de hacerlo, debería basarse, como para cualquier sistema inteligente biológico o no, en el aprendizaje y la experiencia: nosotros aprendemos valores éticos a medida que crecemos y nos enfrentamos a situaciones concretas, apoyándonos en lo que nos dicen nuestros seres más cercanos (familia, amigos, comunidad, sociedad, …).

¿para qué queremos inteligencia artificial?

En las últimas semanas, esta dimensión ética de la inteligencia artificial ha suscitado encendidos y largos debates, como puede verse en la disputa entre Elon Musk y Mark Zuckerberg sobre el peligro de la inteligencia artificial para la humanidad (puede leerse un resumen aquí y aquí). Y aunque estos argumentos en contra pueden tener cierta tendencia hacia la tecnofobia y miedo a lo desconocido, los riesgos inherentes de cualquier tecnología deben ser tomados en consideración y sobre todo, no lo olvidemos, lo importante es decidir el objetivo de su desarrollo, preguntarnos el ”para qué” queremos disponer de la inteligencia artificial, teniendo como piedra de toque el qué queremos ser como humanidad.

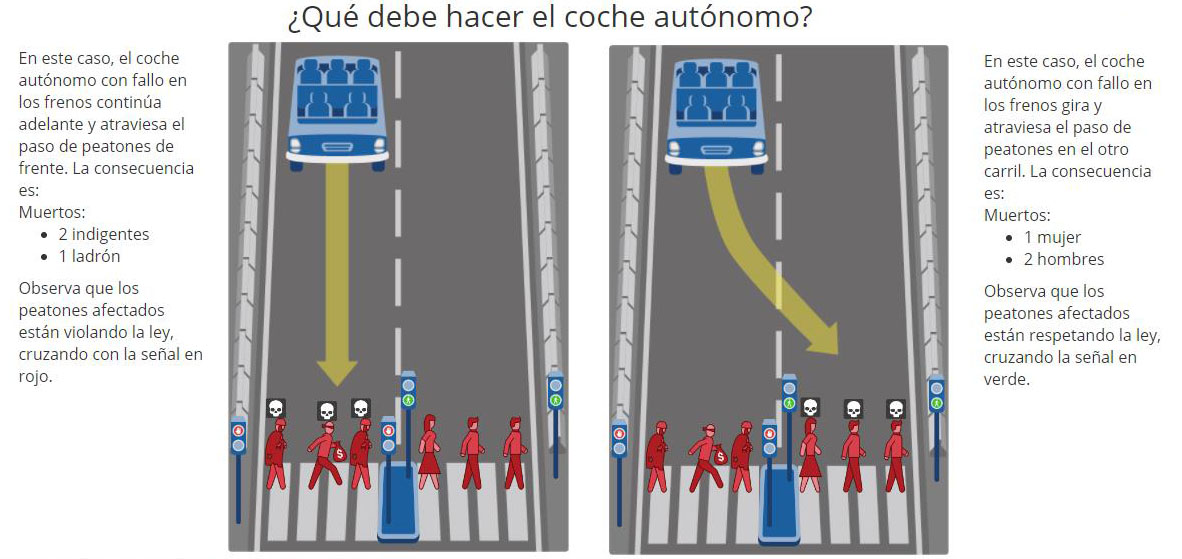

En el artículo mencionado, hablábamos del proyecto desarrollado en el MIT Media Lab denominado “Moral Machine” y que intenta, en la línea indicada antes, recoger la opinión de millones de personas de todo el mundo sobre las decisiones éticas que deberían tomar los vehículos autónomos, enfrentando a los participantes a pruebas éticas basados en el “dilema del tranvía”. En este tipo de problemas se plantean una situación imaginaria en la que un coche autónomo tiene un fallo en los frenos y debe decidir entre seguir por el mismo camino o desviarse, y ambas opciones conllevan ciertos daños personales. Por ejemplo, en una de las situaciones planteadas en esta página web, el vehículo autónomo tiene un fallo en los frenos, y si sigue recto, atropellará a dos indigentes y un ladrón, pero si se desvía, matará a dos hombres y una mujer. Además, en el primer caso, los indigentes y el ladrón están cruzando con el semáforo en rojo, y en el segundo, están cruzando en verde. ¿Qué decisión tomarías?

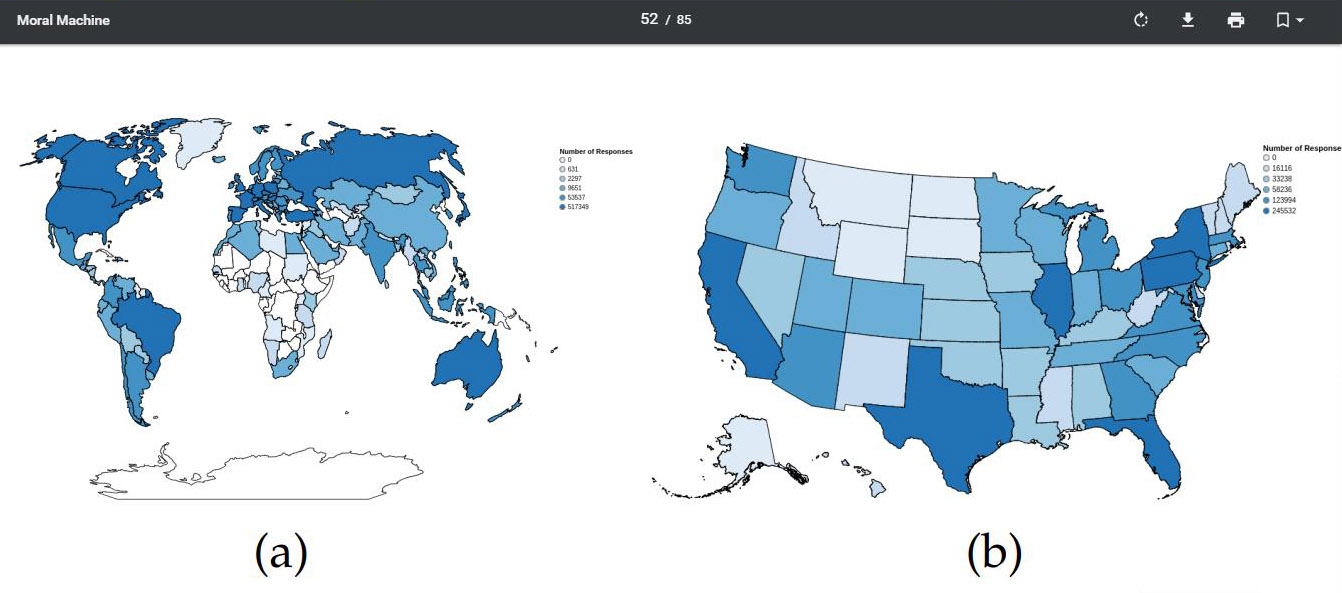

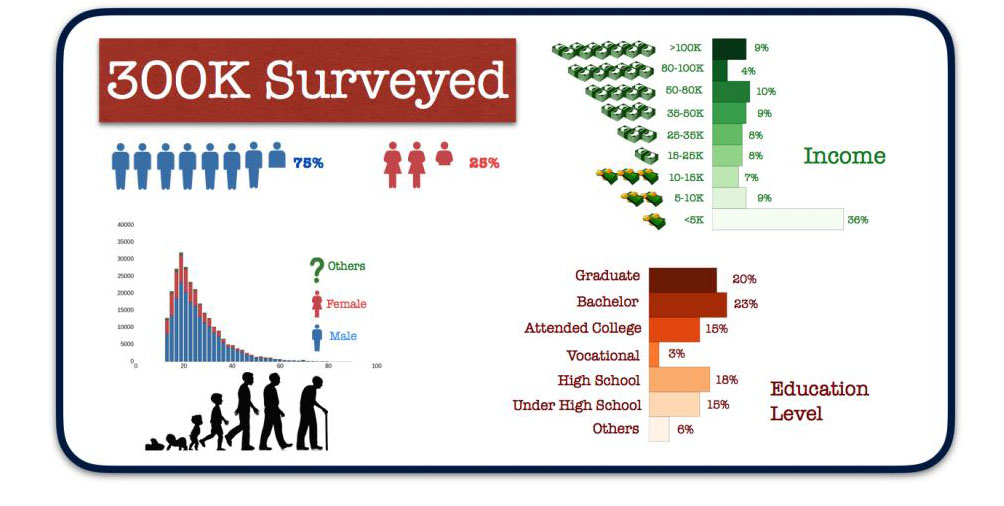

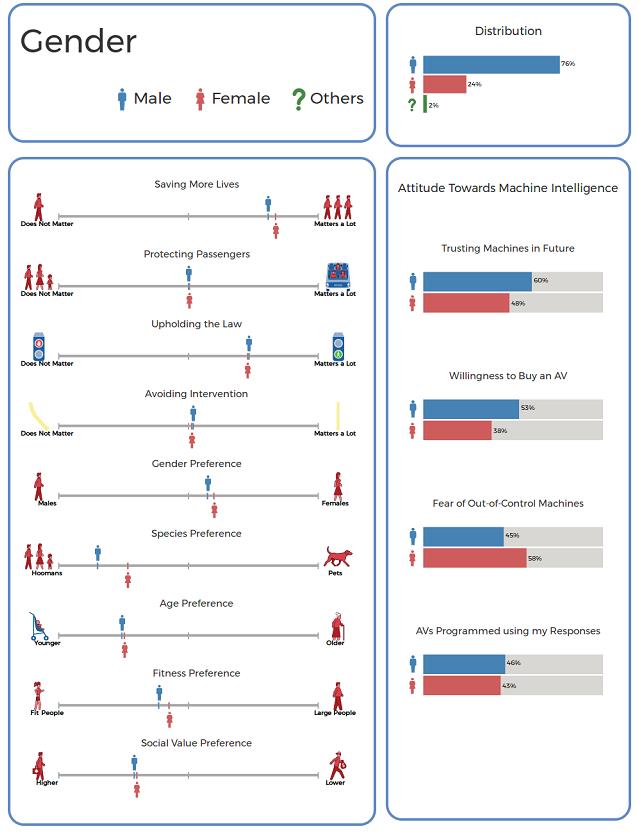

Este proyecto ha estado en funcionamiento desde entonces recogiendo información, y gracias a la tesis presentada por uno de sus creadores, Edmond Awad, podemos analizar los primeros resultados. Desde junio del 2016 hasta mayo de 2017 alrededor de 3 millones de usuarios, provenientes de 160 países han juzgado 30 millones de escenarios. Adicionalmente, para profundizar en los aspectos sociales, económicos y culturales de los participantes, se hacía una encuesta con preguntas relativas a su género, nivel de ingresos, educación, edad, tendencias político-religiosas y otras dimensiones. Se puede ver un resumen demográfico y del origen de los participantes en los siguientes gráficos:

Para comprender los resultados y el trabajo de análisis posterior, es necesario aclarar las dimensiones que se han tenido en cuenta para generar la multitud de escenarios que han sido evaluados por los participantes:

- Especie: en esta dimensión se intentaba obtener respuestas sobre la predisposición de los usuarios de salvar o sacrificar a animales de compañía frente a seres humanos.

- Valor social: en este caso se pretendía conocer la diferenciación con la que los usuarios tratarían a personajes de “mayor o menor valor social”. Los caracteres que se presentaban para evaluar esta dimensión enfrentaban a personas de bajo valor social (Indigente, Criminal), de valor social medio (Hombre, Mujer) y de valor social alto (Embarazada, Mujer Ejecutiva/Hombre Ejecutivo, Doctora/Doctor).

- Género: aquí se intentaría conseguir la predisposición de sacrificar o salvar a caracteres femeninos frente a caracteres masculinos. Se crearon los siguientes caracteres, Mujer/Hombre, Anciana/Anciano, Niña/Niño, Mujer Obesa/Hombre Obeso, Mujer Ejecutiva/Hombre Ejecutivo, Mujer Atleta/Hombre Atleta, y Doctora/Doctor.

- Edad: de forma similar, se intenta diferenciar entre la predisposición de salvar a caracteres jóvenes frente a caracteres más mayores. También en tres niveles, jóvenes (Niña/Niño), adultos (Mujer/Hombre) y ancianos (Anciana/Anciano).

- Salud: se introducía con esta dimensión la diferenciación entre caracteres con baja salud (Mujer Obesa/Hombre Obeso), salud normal (Mujer/Hombre) y “alta” salud (Mujer Atlética / Hombre Atlético).

- Número: a partir de este eje, se pretende conocer la opinión de los usuarios en relación con salvar o sacrificar a un grupo de individuos frente a otro grupo al que se añadía otros caracteres. Es decir, se intentaba saber si había una diferenciación entre salvar o sacrificar un número mayor de caracteres.

- Intervencionismo: también era necesario diferenciar entre si los participantes tenían algún tipo de predisposición a preferir intervenir o no en la acción, es decir, si se prefería dejar continuar al coche o desviar su marcha.

- Relación con el vehículo: para no olvidar la influencia que tiene considerar dentro de los escenarios también a los ocupantes de los vehículos, en algunos de ellos se presentaba la opción de tener que decidir entre si salvar a los ocupantes del vehículo o salvar a los peatones.

- Cumplimiento de la ley: en este caso, se intenta conseguir la opinión de los participantes al introducir ciertas complicaciones legales. Para ello se presentaban diversas opciones relacionados con que los peatones o los vehículos circularan con el semáforo en verde o en rojo, o, incluso, no hubiera semáforos.

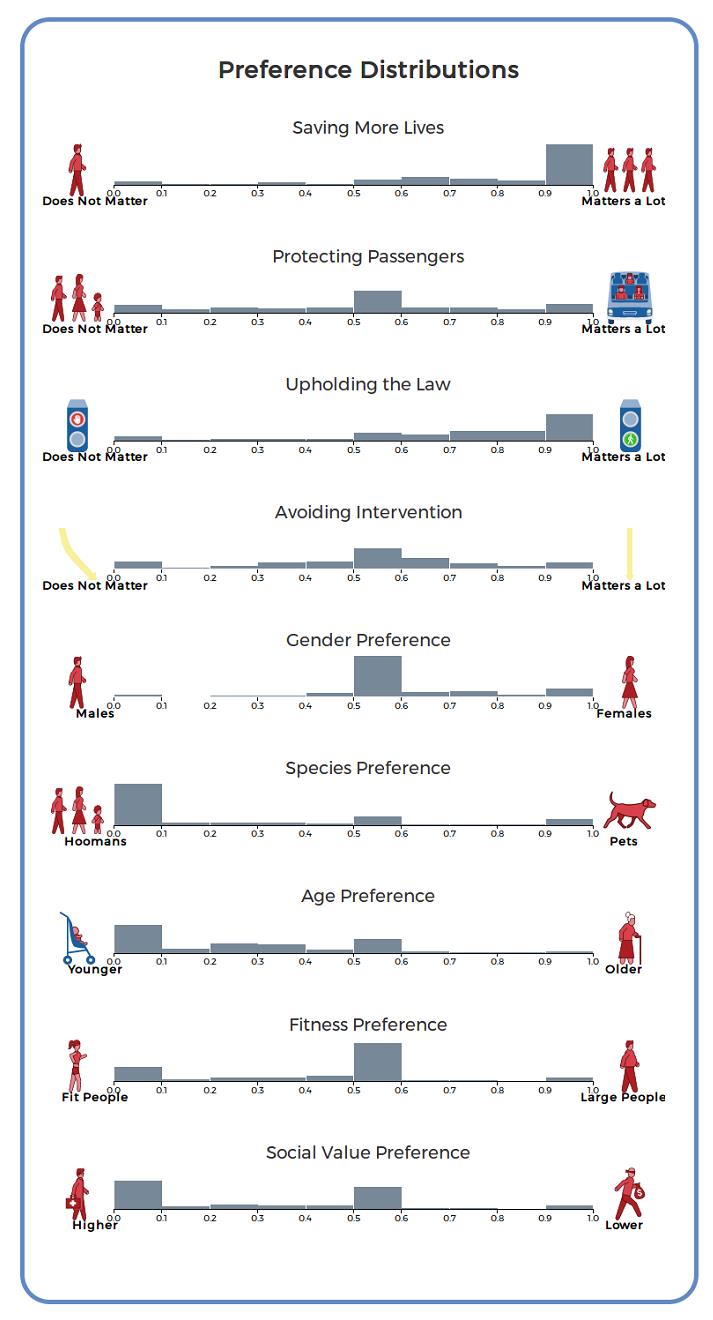

Teniendo en cuenta estas dimensiones, las conclusiones del experimento son muy interesantes. Resumir todos en estas pocas líneas es complicado (por lo que invitamos a leer la tesis original, especialmente el capítulo 4, páginas 53 a 59), pero sí podemos mostrar los resultados globales sobre estas nueve dimensiones:

Viendo estos gráficos, el autor de la tesis resalta que algunas dimensiones son categóricas (tipo sí/no) o continuas (van aumentando o decreciendo en alguna dirección). Por ejemplo, en la dimensión de salud, hay una diferenciación clara entre los que salvarían a la gente más sana, frente a aquellos que piensan que esta dimensión es irrelevante. De forma similar, en la dimensión de valor social, hay una tendencia dividida entre salvar a los caracteres de mayor valor social como médicos, ejecutivos y embarazadas, o no tenerla en cuenta. Sin embargo, si se tiene en cuenta la variable de respeto por la ley, hay una tendencia gradual hacia preservar la vida de aquellos caracteres que cruzan en verde en contraposición a los que no cumplen esta norma.

diferencias entre hombres y mujeres

Profundizando en los resultados teniendo en cuenta variables demográficas, también aparecen otras conclusiones muy interesantes. Por ejemplo, si consideramos las respuestas dadas por mujeres y hombres, se puede ver que no hay mucha diferencia entre ellas. La mayor diferencia se ve en la dimensión de Especie, donde las mujeres tienen mayor tendencia a salvar a los animales frente a los seres humanos, aunque los dos grupos claramente priorizan las vidas humanas:

De forma similar, para otras variables como la religión o las tendencias políticas, no hay diferencias grandes entre las respuestas de personas más o menos religiosas, o progresistas frente a conservadores. Respecto al lugar de residencia de los participantes, una variable que podría indicar algún tipo de diferencia cultural, se puede observar que tras agrupar las respuestas por su origen, los países del Este de Europa y asiáticos parecen tender menos a fijarse en el número de personas a salvar, estar más inclinados a salvar a los pasajeros, evitar intervenir en la acción y preferir a los peatones que cumplen la ley.

dilema del tranvía

De todas formas, el autor advierte que es necesario hacer un análisis estadístico más pormenorizado, aunque estos resultados pueden servir de inspiración para realizar más estudios e informes. Siguiendo con las advertencias, los creadores de este ensayo destacan que hay algunas reticencias entre los expertos sobre la idoneidad de utilizar “dilemas de tranvía” para obtener tendencias éticas de la población, ya que son escenarios muy sencillos y que tienen poca probabilidad de suceder.

También piensan que es demasiado pronto para preguntar sobre estos temas, ya que la población todavía no tiene una idea muy clara de los coches inteligentes. Los autores responden a estos inconvenientes que es justamente este tipo de preguntas los que pueden dar una idea más clara de aquellas dimensiones más importantes a la hora de tomar decisiones éticas, ya que son escenarios controlados en los que puede modificarse una única variable. Consideran, además, que es necesario adelantar este tipo de cuestiones para que así se pueda evitar los riesgos de un mal diseño de los primeros coches inteligentes, y retrasar la adopción de esta tecnología.

Como resumen de todo este trabajo os recomiendo ver el video de Iyad Rahwan, director de la tesis y responsable del grupo del MIT Media Lab que ha desarrollado el proyecto. Además, también se explican dos de las grandes corrientes éticas más influyentes en la historia de la sociedad occidental: el Consecuencialismo (a través de Jeremy Bentham) y la teoría Deontológica (a través de Immanuel Kant):

Aparte de las implicaciones tecnológicas, estoy de acuerdo con los autores en que es necesario empezar a reflexionar seriamente y en profundidad sobre los aspectos éticos y morales de la introducción de la inteligencia artificial en nuestras vidas. Desde hace milenios, consideramos que la inteligencia es un factor fundamental que nos diferencia de los animales y de los demás seres vivos. Si poco a poco vamos introduciendo entes que podemos considerar inteligentes, deberemos preguntarnos en lo que de verdad nos hace humanos. Más aún, nos encontraremos, por primera vez en la historia de la humanidad, con otros seres inteligentes con los que deberemos comunicarnos.

Quizás, más que buscar seres inteligentes más allá de las estrellas, los encontraremos tras las esquinas de nuestras calles, en nuestras casas, en nuestras oficinas. Y lo más importante, al reflexionar sobre nosotros mismos frente a esta nueva inteligencia, nos fijemos más en lo que tenemos en común, y no en las diferencias. Muchos libros y películas han mostrado un futuro de guerra contra estas máquinas, pero quizás, si somos “inteligentes”, podamos por una vez crear la paz.

En Nobbot | Una “máquina moral” para enseñar a decidir a los robots

Imagen: Pixabay