Esta semana se ha hecho público un Proyecto de Informe del Parlamento Europeo que tiene como objetivo tomar medidas anticipadas de los posibles problemas legales (principalmente en materia de indemnizaciones) que puedan surgir del uso de los robots.

El informe parte de la base de que cada vez hay más robots realizando parte de las tareas antes consideradas humanas, y que su masificación requiere leyes que se ajusten a los daños que puedan causar. Desde desperfectos físicos al paro que puedan provocar al sustituir puestos de trabajo.

Un informe para gobernarlos a todos

El enfoque bajo el que se redacta el informe al completo se vende como un paraguas de protección ante desperfectos, pero una lectura pormenorizada nos enseña aspectos no tan visibles y de gran calado a futuro. Aspectos que tienen que ver con los derechos que pudiera tener un robot inteligente llegado el día.

El informe al completo podría entenderse desde un punto de vista empresarial como un vector que apunta a quién le cae el marrón de un error robótico. Por ejemplo, sobre quién tiene que indemnizar cuando una cosechadora inteligente golpea a un vehículo por error, si el diseñador del hardware, del software, el usuario o la distribuidora, entre otros.

Sin embargo, del mismo documento emergen conceptos relativos al derecho civil humano que destrozan o tiran por tierra cualquier posible derecho civil robótico que pudiese plantearse en el futuro. Así, los robots tendrán estos maravillosos derechos:

- El derecho de servir a los humanos

- El derecho a ser identificados y marcados como robots

- El derecho a ser apagados si no nos gusta su comportamiento o lo consideramos peligroso en cualquier modo

- El derecho a ser una posesión

- El derecho a ser considerado una persona electrónica si es suficientemente inteligente

- El derecho a ganar dinero, pero solo si es para cubrir un desperfecto que pudiesen ocasionar

Surge una no tan pequeña paradoja cuando uno se toma lo suficientemente en serio las tres leyes de la robótica planteadas por Isaac Asimov como para incluirlas en un informe europeo (aparecen en las primeras hojas del informe) pero no atiende a las consecuencias que el mismo divulgador científico planteó sobre las rebeliones del robot oprimido.

Página 5 de 24 del informe. Fuente: PR\1095387ES.doc

En el informe se menciona que «la responsabilidad civil de los robots es una cuestión fundamental que debe abordarse a escala de la Unión con el fin de garantizar el mismo grado de transparencia, coherencia y seguridad jurídica en toda la Unión Europea para beneficio de los consumidores y las empresas [24]» pero no se dice nada del beneficio de los robots, suponiendo que exista tal cosa.

Pero vayamos por partes. Primero, busquemos futuros culpables de destrozos robóticos.

¿De quién es la culpa si el robot provoca daños accidentales?

En la actualidad, si un robot (supongamos una aspiradora automática) causa un desperfecto, la ley dice que el culpable es un humano. Así lo dice el informe cuando asegura que «en el actual marco jurídico, los robots no pueden, en sí mismos, ser considerados responsables de los actos u omisiones que causan daño a terceros [U]» y que siempre es «posible remontarse hasta un agente humano concreto».

«Llegué a casa del brunch para descubrir que la aspiradora Roomba había golpeado y roto un gran espejo en mi cuarto». Fuente: Shane Becker.

En otras palabras, que si un vehículo autónomo hoy día machaca sin querer un vehículo aparcado, el culpable será la marca que lo programó, exactamente en el mismo marco que si fuese una batidora fuera de control o un tostador averiado, dado que todavía la ley no contempla que haya una mínima inteligencia robótica.

Aunque, como ya se venden robots que la tienen, aparecen propuestas interesantes a lo largo del informe, como que la actual «normativa general sobre responsabilidad resulta insuficiente y precisa de nuevas normas que se centren en cómo una máquina puede considerarse parcial o totalmente responsable de sus actos u omisiones [S]».

Esto tiene cierta lógica, especialmente en un marco en el que sabemos que los robots se están volviendo más inteligentes, y previendo un futuro en el que el autoaprendizaje exceda la programación base que le puso el fabricante o las órdenes directas dadas por el dueño del robot.

La cara de ya estaba así cuando llegué les servirá de poco. Fuente: Bar-Ilan University.

Llegado ese punto, ¿por qué no transferirles ciertas responsabilidades por los daños que puedan causar, especialmente si se han averiado o están defectuosos?

Averiado, o defectuoso, es la clave del actual vector legal de culpabilidad, porque solo la Directiva Europea 85/374/CEE (de 1985) toca el tema de los robots de manera tangencial (por supuesto sin aparecer la palabra robot por ningún lado, sino producto), aludiendo a los daños causados por productos defectuosos.

¿En qué momento la independencia de una IA se considerará un defecto?

Una de los puntos que preocupan en el informe es «que la programación de un robot falle [F]», pero sin aclarar en ningún momento en qué consiste un fallo de la programación. ¿Se entiende como fallo que el robot no haga lo que se le ha pedido, o que presente un comportamiento errático e ilógico?

Supongamos que le pedimos a nuestro robot-aspiradora que vuelva al trabajo porque se haya detenido en mitad del pasillo. Pongamos dos posibles respuestas:

- El robot se ha quedado bloqueado, incapaz de realizar su trabajo, o incluso puede ponerse a arañar el suelo por error. Quizá fruto de una telemetría deficiente que le hacen imposible la labor, o porque no puede comprender sobre qué clase de suelo está. Resulta obvio que se ha estropeado en cierta medida.

- Que el robot diga que no desea seguir haciendo eso. Y aquí entramos en un campo que traerá cola en años venideros.

¿Qué derecho tenemos nosotros para obligar a un robot a hacer algo que no quiere hacer, inclusive si hemos pagado por él? ¿Tenemos derecho a acabar con su existencia? Pues sí, según el informe.

Uno de los puntos clave del informe, medio escondido en el apartado Licencia para los diseñadores exige: «Los diseñadores deberán integrar mecanismos de salida evidentes (teclas de interrupción de urgencia) que deberán ser coherentes con los objetivos de diseño razonables». Es decir, que si el objetivo de mi robot inteligente es fregar y él no quiere, podré desactivarle.

Esto, que suena a cachondeo cuando hablamos de una aspiradora automática moderna, quizá no sea tan gracioso en el futuro, cuando se compare la trayectoria animalista y de protección de la vida salvaje con otro tipo de seres conscientes.

Aunque al principio de la era de la IA la consciencia no exista dentro de los robots, las más altas instancias del campo de estudio aseguran que la singularidad acabará por aparecer de manera natural tras el esfuerzo realizado. Es decir, que existirá un punto a partir del cual el robot tomará consciencia de sí mismo, y pasará a usar el complemento lo (neutro) a le (aplicado hoy día a humanos y personificaciones en la ficción).

Hace años los perros biológicos no tenían derechos, como no los tienen ahora los perros-bot. ¿Llegaremos a dárselos cuando sean lo suficientemente inteligentes? Fuente: CFVI

Si redactamos ahora un marco legal en el que les ponemos lo que han llamado botón de la muerte por los expertos, ¿qué pensarán estos robots cuando despierten en un mundo que los ha convertido en esclavos? ¿Tenía razón Asimov cuando dijo que si les arrinconamos se revelarán?

Pero, si no los tratamos como una posesión, ¿qué derechos merecen?

Los derechos de los robots

En el informe se les otorgan derechos parciales. Resulta curioso que en un informe en el que se solicita que se les pueda apagar cuando nos plazca se les dé también derechos sobre el Copyright de sus posibles obras. De hecho, se pide que se «elabore criterios relativos a una “creación intelectual propia” aplicables a las obras protegidas por derechos de autor creadas por ordenadores o robots».

Es decir, que quizá en el futuro un robot podrá ser dueño de una obra de arte creada por sí mismo, a pesar del hecho de no poder ser dueño de sí mismo. Una pequeña paradoja que igual nos conviene solucionar.

En el lado de la balanza de derechos robóticos aparece el que «puedan ser considerados personas electrónicas con derechos y obligaciones específicos [31.f]», pero llama muchísimo la atención que en ninguno de esos párrafos se hable sobre esos supuestos derechos, y sí de sus obligaciones. Como la «obligación de reparar los daños que puedan causar [31.f]» o la obligación de poseer un «número de inscripción individual que figure en un registro específico de la Unión [31.e]».

Además, queda de lado el tema de que un robot pueda defenderse en un juicio de ninguna clase cuando se le obligue a reparar algo que haya roto porque se prevé la «aplicación de la responsabilidad objetiva [27]» que «únicamente exige probar que se ha producido un daño y el establecimiento de un nexo causal entre el comportamiento perjudicial del robot y los daños causados a la persona perjudicada [27]».

Malos tiempos futuros para los robots realmente inteligentes. Visto el percal, igual se apagan ellos solos. Ni siquiera les dejamos irse de vacaciones con el dinero que ganen, porque podrán ganarlo.

Aunque hay que decir que la relación del robot con el dinero que se establece en la propuesta es compleja. Por un lado, se habla de «permitir distintas operaciones financieras en interés del robot, tales como inversiones, donaciones o la remuneración a robots inteligentes autónomos por sus servicios, que podrían transferirse al fondo [31.b]». Sin embargo, se define claramente el fondo mencionado como un fondo de compensación por posibles desperfectos que el robot pueda ocasionar cuando los seguros no se pongan de acuerdo.

Es decir, se le permite guardar cierto capital pero no para su disfrute, sino para cuando rompa algo. No me imagino a los humanos yendo felices a trabajar sabiendo que el dinero que ganen será solo por si destrozan algo de vuelta a casa.

A favor de la ética, pero solo si beneficia a quien puso el dinero.

El informe habla de manera continua de una ética y un saber hacer, pero teniendo en cuenta que la visión actual de supremacía del ser humano ante las futuras Inteligencias Artificiales es absoluta o casi absoluta, el informe deja claro que se está a favor de la ética pero solo si beneficia a quien puso el dinero para producir el robot.

La visión occidentalizada de los robots (en oriente se tiene un punto de vista antagónico), dejan al robot a la altura del nombre que Karel ?apek les puso. En eslavo robota significa esclavo, y en checo, trabajo. Algo que, ante versiones avanzadas de las IA desmantela el pretexto de ética que pide el propio informe. ¿Se puede ser ético (no ya digamos moral) si explotamos a un ser inteligente en contra de su voluntad bajo pena de apagado?

¿Cómo podemos justificar querer enseñar ética a los robots si nosotros la obviamos?

Pero claro, el informe está redactado por humanos y para humanos, que también tenemos nuestros derechos autoasignados por nosotros mismos. Derechos que, por descontado, nos encanta inflar.

Los derechos de los humanos

La llegada de los robots lleva causando polémica desde hace años. Desde el pesimista los robots nos dejarán en paro al utópico los robots lo harán todo por nosotros y no tendremos que trabajar, el debate está servido. Pero como a día de hoy los humanos ya tenemos problemas con la falta de trabajo o con las pensiones, no es raro que el informe establezca determinados puntos a nuestro favor.

Por ejemplo, se plantea una renta básica universal [23] exigible de las empresas que más trabajadores robóticos usen para su beneficio. Por ejemplo, cotizando a la seguridad social por cada robot que saque trabajo adelante.

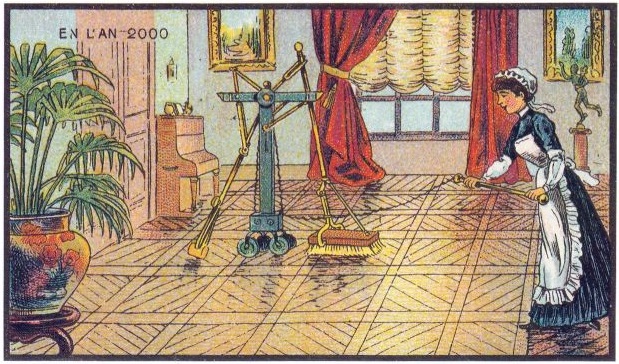

Idea que se tenía en 1899 del robot eléctrico del año 2000 que liberaría al mundo del trabajo.Fuente: Wikipedia.

También se pide que los robots, como los coches a día de hoy, se enmarquen en un régimen de seguro obligatorio [31.a] que cubran sus desperfectos. No vaya a ser que sea complicado determinar de quién es la culpa, o que cuando no haya culpable el robot no pueda reparar o pagar los daños.

En el punto de asignar responsabilidades (hemos vuelto a ver a quién le cae el marrón) aparece también la figura de profesor [28]. Como es un informe muy abierto, y para cubrir todas las posibilidades futuras, se plantea que el robot pueda llegar a ser suficientemente inteligente como para aprender más allá de su programación base o de cumplir las órdenes de su dueño. Así, puede haber profesores, o personas que le enseñen algo al robot o le animen para causar desperfectos y daños, y cuya «responsabilidad será proporcional al nivel real de las instrucciones dadas a los robots y a su autonomía, por lo que cuanto mayor sea la capacidad de aprendizaje o la autonomía, menor será la responsabilidad de las otras partes, y cuanto más larga haya sido la “educación” del robot, mayor será la responsabilidad de su “profesor” [28]».

Algo que plantea más dudas que respuestas. ¿Qué ocurre si un robot propiedad de una empresa aprende algo de un ciudadano por la calle y, aplicándolo, crea un desperfecto en esa empresa? Tras un análisis del cerebro de la IA, ese ciudadano podría ser señalado como la persona que imprimió el pensamiento original en el robot para romper algo. ¿Hasta qué punto este ciudadano anónimo en principio tiene responsabilidad? Pues el informe no lo dice.

Un análisis en profundidad del texto da a entender que, más allá de buscar culpables a accidentes (que sí), el informe busca limitar mucho los posibles derechos robóticos (suponiendo siempre que estos los lleguen a tener). Aunque hace referencia a una «revisión de la legislación pertinente a su debido tiempo [25]» esto se plantea a 10 o 15 años.

¿Qué pasa si una IA emerge dentro de ocho? ¿Podremos explotarla sin revisar sus posibles derechos, o desconectarla antes de que pueda solicitarlos? El debate está servido.

Lo más importante: Tú, ¿qué opinas?

En Nobbot | Periodismo e inteligencia artificial, ¿peligra la profesión?

Imágenes | ZombMax, Autopilot, Angry Droid, frankieleon

Actualización 23.02.2017 con este vídeo de Kurzgesagt: ¿Merecen los robots tener derechos? ¿Qué ocurre si los robots adquieren consciencia?