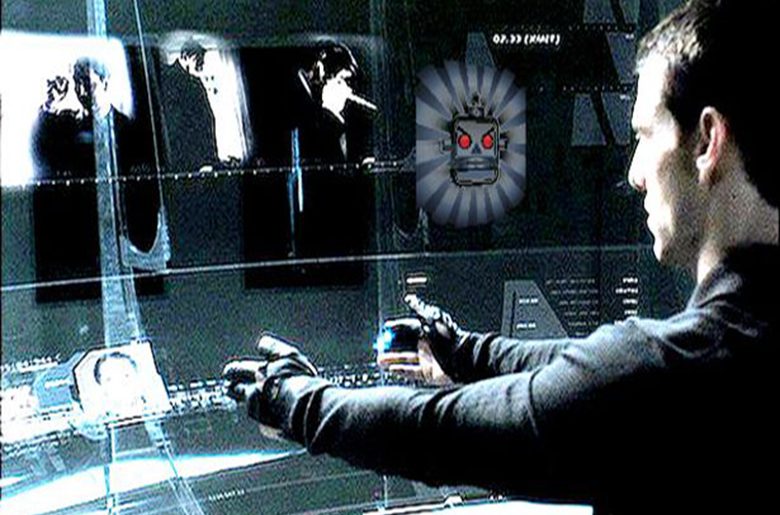

Los aficionados al cine de ciencia ficción tienen a Minority Report como un referente de culto en el género y al autor del relato en que se basa, Philip K. Dick, como un Julio Verne de nuestro tiempo. Y no solo por la originalidad de esta historia, llevada a la gran pantalla por Steven Spielberg con su habitual maestría, sino sobre todo por el debate que generó en el momento de su estreno la posibilidad de que el progreso tecnológico permitiera algún día la detección previa de delitos, con todas las derivadas éticas que eso implica.

En 2002, dicha eventualidad se antojaba aún lejana. Y es que, cuando la comunicación móvil todavía estaba, como quien dice, despegando, poco podíamos imaginar lo que iba a evolucionar nuestra sociedad en material tecnológica en poco menos de veinte años. Tanto así que ya no necesitamos humanos «precog» que vaticinen con sus visiones futuros hechos delictivos. Gracias al Big Data y la inteligencia artificial, anticipar con notable acierto la probabilidad de que alguien vaya a cometer crímenes en un horizonte temporal cercano es algo más que factible; es muy real.

En Australia, por ejemplo, la fuerzas del orden de Nueva Gales del Sur ya están poniendo en práctica estos equipos de «policía preventiva». Y su aplicación no está exenta de polémica, como también predecía el autor de la igualmente lúcida «¿Sueñan los androides con ovejas eléctricas?» (más conocida por su traslación al celuloide como «Blade Runner») . Según nos explican en Mashable, en este estado australiano se ha empezado a utilizar una herramienta conocida como «Plan de Gestión de Objetivos Sospechosos» (STMP, por sus siglas en inglés), que, utilizando un algoritmo, evalúa el riesgo de reincidencia de una persona una vez ha cometido su primer delito.

El programa calcula la probabilidad de que el sujeto en cuestión vuelva a delinquir y lo clasifica según en peligro de reincidencia en extremo, alto, medio o bajo. De esta forma, los agentes pueden optimizar sus esfuerzos, centrándose en los infractores reincidentes más probables con el objetivo de prevenir crímenes futuros.

¿TIENE PREJUICIOS LA I.A. DE MINORITY REPORT?

De entrada, tiene todo el sentido utilizar la lógica racional y objetiva de la tecnología para la prevención del crimen. Pero, ¿y si esta también tuviera «prejuicios»? En relación a esto, cabe recordar la investigación que han realizado este mismo año científicos de la Universidad de Princeton (EEUU) y de la Universidad de Bath (Reino Unido) demostrando que, cuando los sistemas de inteligencia artificial aprenden un idioma a partir de textos ya existentes, se ven contagiados de los mismos prejuicios raciales o de género incluidos en el lenguaje.

Los resultados del estudio, que se publicaban en abril en la revista Science, aportaban sin duda una interesante visión sobre cómo se transmiten este tipo de sesgos en el comportamiento humano y la relación que tienen con el lenguaje y los estereotipos culturales. Y también cómo estos mismo prejuicios se contagian a las influenciables mentes artificiales.

De la misma forma, un informe de la Coalición por la Justicia Juvenil sobre el controvertido programa policial australiano revela que el algoritmo del STMP, basándose en este caso en historiales criminales, actividades sospechosas y otros factores del entorno, también sesga el foco hacia la población joven aborigen (el 44% de los sospechosos pertenecen a este colectivo) y que muchos de los indiduos «señalados» no tienen sino condenas menores (o ninguna pero han sido detenidos de forma esporádica). Si a ello se une que la investigación arranca desde edades tan tempranas como los 11 años o las denuncias sobre el hostigamiento policial a que se somete a esos futuribles sospechosos, la polémica está más que servida.

Entre los ejemplos citados en esta investigación para apoyar sus conclusiones está el de un adolescente de solo 16 años cuya detención se justificó en algo tan peregrino como que «los jóvenes que suben al último vagón de un tren y utilizan la marca de ropa Nautica tienen más tendencia a cometer daños materiales o hacer graffitis». Unas pruebas muy débiles, como terminó descubriendo en su propia experiencia el protagonista de «Minority Report».

Es por ello que, aunque el departamento de policía de Nueva Gales de Sur haya argumentado que el STMP es solo una estrategia más de prevención del delito tras la cual están profesionales con experiencia, el informe recomienda que se suspenda su uso para menores de 18 años y que el programa sea meticulosamente investigado por un organismo independiente de vigilancia policial independiente.

EN ESTADOS UNIDOS YA TIENEN EXPERIENCIA EN EL PRE-CRIMEN

La australiana no es la primera experiencia en la que la minería de datos se ha convertido en una herramienta al servicio de las fuerzas del orden o de las autoridades gubernamentales, al más puro estilo de esa sección especial de pre-crimen de «Minority Report». En este sentido, Estados Unidos lleva una vez más la delantera, con ejemplos tan significativos como el de la misteriosa firma tecnológica Palantir Tecnologies.

Esta innovadora compañía, fundada en 2004, entre otros, por el también creador de PayPal, Peter Thiel (a cuya pasión por J.R.R. Tolkien debe su nombre), se describe a sí misma como una entidad que trabaja por el bien común a través del «desarrollo de software para conectar datos, tecnologías, seres humanos y entornos».

De ella se dice que su extraordinaria capacidad y especialización en el procesamiento de cantidades masivas de datos para extraer información valiosa (como hacían esas piedras videntes Palantir de «El Señor de los Anillos») permitió al Gobierno estadounidense localizar nada menos que a Osama Bin Laden o a perseguir a los cárteles de la droga. Rumores o no, sus vínculos con la comunidad de inteligencia norteamericana vienen de largo, si bien se habrían enfriado en los últimos tiempos, según nos explican en BuzzFeed. Baste decir que la unidad de capital riesgo de la CIA, conocida como In-Q-Tel, invirtió nada menos que 2.000 millones de dólares en esta prometedora start-up, que más tarde se hizo con importantes negocios con diferentes agencias y departamentos gubernamentales, y que algunos ligan a las labores de espionaje de la agencia de inteligencia estadounidense.

Y he aquí donde llegamos de nuevo a las implicaciones éticas que empañan el uso de la inteligencia artificial y el análisis de datos cuando los límites en el uso que se hace de estas tecnologías a la hora de investigar o perseguir el crimen no quedan claros o se sobrepasan. En cualquier caso, no nos equivoquemos; la tecnología no es más o menos moral y no entiende de ética. Somos los humanos quienes hemos de establecer esos límites, sin dejar por ello de aprovechar los increíbles beneficios que nos reporta el avance tecnológico. El protagonista de «Minority Report» lo vio claro cuando hubo de elegir entre evitar un crimen y detener a quien podría, pero aún no lo había cometido. En nosotros está la capacidad de elección.

Fuentes | Mashable, Buzzfeed, News.com

Imágenes | Pixabay, Pinterest

En nobbot | La inteligencia artificial reproduce prejuicios raciales y de género