¿A qué suena ‘El beso’ de Gustav Klimt? ¿Qué clase de tormento sonoro surge del ‘Saturno devorando a un hijo’ de Francisco de Goya?

Los cuadros no tienen música, podríamos pensar. Son obras silenciosas y meramente visuales. La postura de los amantes y los colores cálidos transmiten la ternura y el amor de la obra de Klimt. La expresión de Saturno y la oscuridad nos horrorizan en el cuadro de Goya. Por mucho que intentemos ponerlo en palabras, no hay nada como poder ver la obra.

Hasta ahora, las personas ciegas o con discapacidad visual estaban privadas en gran medida de los sentimientos que genera la pintura. Sin embargo, gracias a un modelo de inteligencia artificial y al ingenio de cinco jóvenes, esta discriminación podría tener los días contados. Han creado una tecnología que permite extraer los sentimientos de un cuadro y transformarlos en música. Han logrado que la gente que no ve pueda escuchar la pintura.

Matemáticas que ven, matemáticas que componen

La idea de crear una inteligencia artificial capaz de ayudar a las personas invidentes a disfrutar de la pintura surgió en un curso de aprendizaje de deep learning organizado en Madrid por Saturdays AI. Al final, había que elaborar un proyecto que demostrase lo que cada uno de los participantes había aprendido.

“Nos reunimos los del equipo y decidimos que podíamos usar la oportunidad para hacer algo útil y generar un impacto positivo”, explica Guillermo García, estudiante del Doble Grado de Matemáticas e Informática de la Universidad Autónoma de Madrid. “La primera idea fue una IA para componer música. Nos parecía divertido, pero nos faltaba el punto de utilidad. Después de darle muchas vueltas y comentarlo con la familia, a mi novia se le ocurrió que podíamos juntar la composición con análisis de imagen para ayudar a las personas ciegas a escuchar los cuadros”.

Junto a Guillermo García, detrás del proyecto están Miguel Ángel Reina, analista de datos, Diego Martín, científico de datos e ingeniero aeroespacial, Sara Señorís, física y científica de datos, y Borja Menéndez, doctor en investigación operativa. Entre todos dieron con un modelo que en realidad son dos inteligencias artificiales: una red neuronal convolucional y una generative adversarial network o GAN. El nombre de su tecnología lo tuvieron en bandeja: GANs N’ Roses.

“La lógica detrás del proceso se divide en dos partes. Lo primero que tenemos es un modelo entrenado para detectar sentimientos en un cuadro e informarnos de su distribución. Es decir, este es un cuadro con un 50 % de felicidad, un 30 % de amor y un 20 % de tristeza”, explica Guillermo García. Aquí es donde entra en juego la red neuronal convolucional. Esta funciona en ciertos sentidos de forma similar a las neuronas de la corteza visual primaria del cerebro.

Esta red fue entrenada con el conjunto de datos de The Wikiart Emotions Dataset, en el que figuran más de 4000 obras de diferentes estilos de la tradición pictórica occidental. A partir de ahí, crearon un modelo de distribución de las emociones de cada cuadro, algo que pudiesen utilizar para darle las indicaciones a la segunda inteligencia artificial, la GAN.

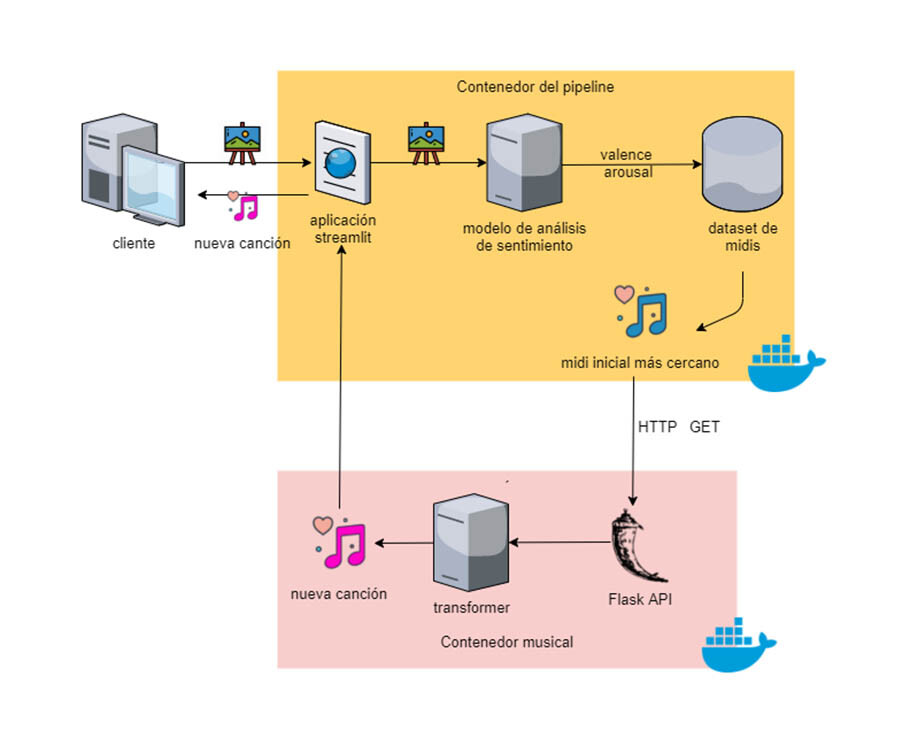

“Este segundo modelo funciona casi como un compositor humano. Necesita cierta inspiración a partir de la cual dar rienda suelta a su creatividad. La distribución de sentimientos del primer modelo la usamos para seleccionar una pieza de música ya existente que se ajuste lo mejor posible a dicha distribución. Una vez seleccionada, le damos los primeros cinco segundos al modelo compositor. Y este genera una pieza única y original de dos o tres minutos”, añade Guillermo García.

Así, a muy grandes rasgos, el modelo de GANs N’ Roses consiste en una IA capaz de analizar un cuadro y traducirlo en una distribución de sentimientos y una plataforma que permite seleccionar una canción ya existente en base a esa distribución para inspirar al director de orquesta, una inteligencia artificial que es capaz de componer algo nuevo en base a lo que ha escuchado.

Una nueva forma de experimentar el arte

El resultado ya se puede ver y escuchar en directo. Desde el pasado mes de octubre, el Museo Tiflológico de la ONCE en Madrid expone una serie de 11 pinturas que pueden escucharse. Gracias a GANs N’ Roses, los visitantes del museo pueden no solo escuchar una descripción textual del cuadro (una medida de accesibilidad cada vez más habitual en los museos), sino escuchar la música creada por un algoritmo para transmitir las emociones de la pintura.

La acogida ha sido tan buena que el museo de la ONCE ha decidido extender la exposición. Estaba pensada para un mes de duración y finalmente permanecerá abierta hasta el 15 de enero. “Por lo que han dicho algunos usuarios invidentes, ahora pueden experimentar los cuadros de una forma más completa. Las exposiciones pueden tener una descripción en audio de los componentes y las técnicas del cuadro, pero eso no te despierta sentimientos. Si le añadimos la música, la cosa cambia”, explica Guillermo García.

De cara al futuro, les gustaría llevar su nueva tecnología a otros museos con mayor impacto, pero en los que la accesibilidad de las obras no siempre está entre las prioridades. “Además, creemos que no solo sirve para ayudar a las personas invidentes, sino que puede crear una nueva forma de experimentar el arte para todo el mundo”, añade García.

De hecho, en su mente está tomando forma ya una nueva idea: explorar el camino inverso. “Lograr un modelo que convierta la música en un cuadro. Tanto para crear una nueva experiencia artística como para ayudar a personas sordas a ver la música”.

En Nobbot | Inteligencia artificial emocional: lo que las máquinas nunca podrán aprender

Imágenes | ONCE, cedidas por Guillermo García