A pesar de la espectacularidad de los vídeos “deepfake” relacionados con política, esta temática no es ni de lejos la más frecuente en estas piezas audiovisuales manipuladas con inteligencia artificial. El 96% de estos vídeos son pornografía.

Este dato se desprende de un estudio realizado por la compañía Deeptrace, especializada en la detección de deepfakes. Este término surgió en 2017 cuando un usuario de Reddit usó el seudónimo “deepfakes” para publicar vídeos de pornografía falsos con rostros de personas famosas. Así que, a la luz de los datos, la naturaleza de estas piezas no se distingue demasiado hoy de lo que eran en su origen.

Desde su aparición, el fenómeno de los deepfake se ha desarrollado rápidamente, tanto en términos de sofisticación tecnológica como en impacto social. Este estudio ha detectado casi 15.000 vídeos manipulados frente a los cerca de 8.000 de hace un año.

Este vertiginoso aumento se debe, fundamentalmente, a la “democratización” de las herramientas que permiten elaborar estas piezas falsas y a los aportes de China y Corea del Sur, donde el fenómeno se extiende a gran velocidad.

publicidad en webs de pornografía «fake»

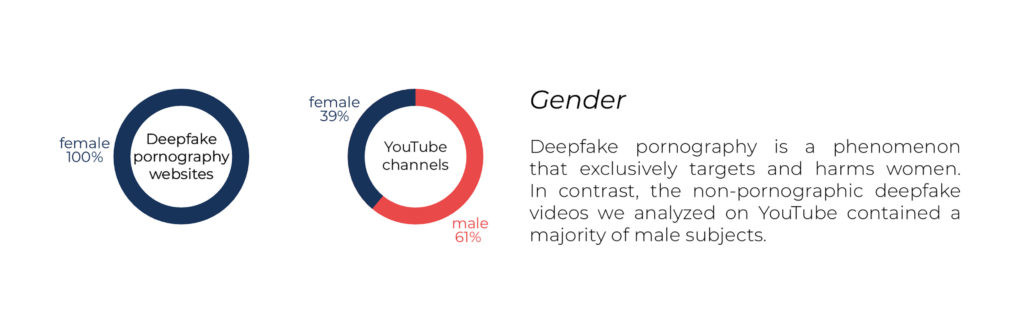

El informe destaca el éxito de las webs que alojan vídeos pornográficos falsos que introducen imágenes de personas famosas ya que, entre los cuatro principales sitios de internet dedicados a esta actividad, suman más de 134 millones de visitas. Las víctimas de la manipulación de estos vídeos son, además, casi en exclusiva a mujeres.

“El hecho de que todos esos sitios web contengan publicidad y haya un claro incentivo financiero o comercial muestran que no van a desaparecer de la noche a la mañana”, dijo Henry Ajder, autor principal del estudio, a Fortune.

la democracia en peligro

la democracia en peligro

En el ámbito político, Deeptrace pone el ejemplo del uso de deepfakes Gabón y Malasia, que han tenido un impacto mínimo en medios de información occidentales, pero que han puesto en peligro la estabilidad de esos países. Por ello, los autores de esta investigación señalan que “sin contramedidas defensivas, la integridad de las democracias en todo el mundo está en riesgo”.

En el ámbito de la ciberseguridad, la utilización de audios de voz sintéticos e imágenes de personas inexistentes comprometen las estrategias de seguridad de empresas y gobiernos.

El «truco» para realizar estos vídeos se encuentra en un algoritmo de inteligencia artificial conocido como Redes de Confrontación Generativa (GAN), que están compuestas por una especie de red neuronal que cuenta con dos fuerzas dominantes: la discriminatoria y la generadora. Ambas luchan entre sí de forma constante para perfeccionar la generación de imágenes y obtener un mayor realismo en las personas representadas. En la web «Esta persona no existe», desarrollada por el ingeniero Phillip Wang, podemos ver el potencial de esta tecnología.