Las aplicaciones de reconocimiento facial están cada vez más extendidas e incluyen desde el acceso al teléfono móvil hasta aplicaciones de videovigilancia o de investigación criminal. Pero cometen errores como confundir a Zoë Kravitz con un hombre.

¿Hasta qué punto esta tecnología es fiable? ¿Qué problemas escondidos podemos encontrar en su uso? Y, sobre todo, ¿qué podemos hacer para minimizar o hasta neutralizar el impacto de estos problemas?

Las aplicaciones de reconocimiento facial están cada vez más extendidas e incluyen desde el acceso al teléfono móvil hasta aplicaciones de videovigilancia o de investigación criminal. Pero cometen errores como confundir a Zoë Kravitz con un hombre.

¿Hasta qué punto esta tecnología es fiable? ¿Qué problemas escondidos podemos encontrar en su uso? Y, sobre todo, ¿qué podemos hacer para minimizar o hasta neutralizar el impacto de estos problemas?

El reconocimiento facial parecía algo exclusivo de los seres humanos e imposible para las máquinas, pero hoy es un problema ya resuelto gracias a la reciente evolución de las redes neuronales de aprendizaje profundo y, en general, de la inteligencia artificial. Gracias a ellas el paradigma clásico de detección, extracción de características y clasificación ha quedado obsoleto.

Ya no es necesario ajustar decenas de parámetros y mezclar diferentes algoritmos para el reconocimiento facial. Ahora, simplemente, las redes aprenden de los datos que les suministramos y que están convenientemente etiquetados.

Muchos aciertos en el reconocimiento facial, pero también errores

Los resultados del reconocimiento facial son espectaculares en cuanto a los ratios de reconocimiento correcto que se consiguen con las redes neuronales. El teléfono siempre te reconoce, el acceso biométrico a tu empresa no falla nunca, las cámaras de vigilancia acaban siempre detectando al sospechoso.

¿O puede que esto no sea siempre así?

Robert Julian-Borchak Williams seguramente no estaría de acuerdo. Este ciudadano afroamericano tiene el dudoso honor de ser el primero en haber sido arrestado porque un algoritmo de reconocimiento facial lo identificó de forma incorrecta.

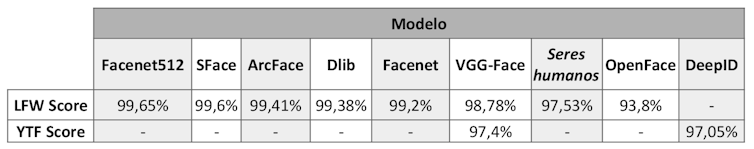

Ratios de reconocimiento correcto de diferentes modelos de reconocimiento facial. Los datos han sido proporcionados por los autores de los algoritmos y se han obtenido sobre las bases de datos Labeled Faces in the Wild (LFW) y Youtube Faces in the Wild (YTF).

El que este primer error se haya cometido con un afroamericano no parece ser una casualidad. Aunque el caso de Julian-Borchak Williams ocurrió en 2020, ya en 2018 la investigadora Joy Buolamwini publicó un estudio donde mostraba que los sistemas de reconocimiento facial tenían dificultades para identificar a las mujeres de piel oscura. Su trabajo trascendió al gran público a través del documental Coded Bias (Sesgo codificado).

Porque sí, parece que las mujeres también han sufrido discriminación por parte de la inteligencia artificial. El famoso algoritmo de Amazon que discriminaba los currículums donde aparecía la palabra “mujer” es su exponente más claro. Afortunadamente, dejó de usarse al comprobar esa tendencia sexista.

No, Zoë Kravitz no es un hombre

Para comprobar si es posible encontrar sesgos en los modelos de reconocimiento facial, en un experimento reciente se propuso a tres grupos de estudiantes que analizaran (de forma independiente) el funcionamiento de diferentes modelos. Los modelos examinados fueron los que se usan en la librería DeepFace.

La evaluación pretendía elegir el mejor modelo en cuanto a porcentaje de reconocimiento. En este caso los resultados obtenidos coincidieron aproximadamente con los presentados por los autores de los modelos. Los pocos fallos detectados involucraban normalmente a mujeres y también a personas de piel oscura. Es destacable que también fallaba la detección de la cara en personas de color en algunos modelos. No es que no se reconociera, sino que el modelo ni siquiera detectaba una cara.

Estos modelos también se pueden usar como estimadores de género, edad y etnia. Para este experimento el modelo usado fue VGG-Face. La estimación de género funcionó bastante bien con personas europeas, pero no tan bien con asiáticas o afroamericanas. El error más común fue confundir mujeres con hombres cuando eran de esas etnias. El resto de estimadores (edad, etnia) no funcionaron bien. La división por etnias quedó claro que era bastante artificial y sujeta a múltiples errores.

¿Cómo pueden confundirlas con hombres?

Estos resultados no nos deben hacer creer que esta tecnología es inútil. En realidad, su capacidad de reconocimiento es superior a la humana en muchos casos. Y, por supuesto, a una velocidad inalcanzable por ningún ser humano.

¿Qué podemos hacer?

Desde nuestro punto de vista, es importante fijarnos en las posibilidades que la inteligencia artificial tiene como herramienta y no despreciar su uso cuando detectamos problemas como los mostrados aquí. La buena noticia es que, una vez detectados los problemas, surgen iniciativas y se hacen estudios para mejorar su uso.

Los sesgos en los modelos aparecen por múltiples motivos: una mala elección de los datos, un mal etiquetado de los mismos, la intervención humana en el proceso de creación y elección de modelos, una mala interpretación de los resultados.

La inteligencia artificial, considerada un avance tecnológico sin prejuicios, se convierte en un fiel reflejo de los sesgos propios y las desigualdades de la sociedad en la que se desarrolla. Como bien se concluye en este interesante artículo, “puede ser una oportunidad para reconstruirnos y no solo lograr algoritmos sin sesgos, sino además una sociedad más justa y fraterna.”

Tenemos las herramientas técnicas para lograrlo. Los desarrolladores pueden encontrar modos de probar y mejorar sus modelos. La iniciativa AI Fairness 360 es un ejemplo de ello. Pero, quizás, lo más sensato sea tirar de sentido común y usar la inteligencia artificial de manera inteligente.

Un ejemplo de esto último lo podemos encontrar en este estudio, donde se concluye que la mejor opción para reconocer con garantías a las personas es que los humanos y las máquinas colaboren. Y también el planteamiento de la Policía Nacional española para hacer uso del sistema ABIS de reconocimiento facial: “Es siempre una persona, y no el ordenador, quien determina si hay o no parecido.”

![]() Hilario Gómez Moreno, Profesor titular de universidad. Teoría de la Señal y Comunicaciones, Universidad de Alcalá; Georgiana Bogdanel, Analista Forense Informático en BDO Spain y Doctoranda en Ciencias Forenses, Universidad de Alcalá y Nadia Belghazi Mohamed, Personal Investigador y Doctoranda en Ciencias Forenses, Universidad de Alcalá

Hilario Gómez Moreno, Profesor titular de universidad. Teoría de la Señal y Comunicaciones, Universidad de Alcalá; Georgiana Bogdanel, Analista Forense Informático en BDO Spain y Doctoranda en Ciencias Forenses, Universidad de Alcalá y Nadia Belghazi Mohamed, Personal Investigador y Doctoranda en Ciencias Forenses, Universidad de Alcalá

Este artículo fue publicado originalmente en The Conversation. Lea el original.