Entramos buscando respuestas acerca del cambio climático y acabamos en un vídeo de teorías terraplanistas. ¿En qué momento tomamos la decisión que nos llevó allí?

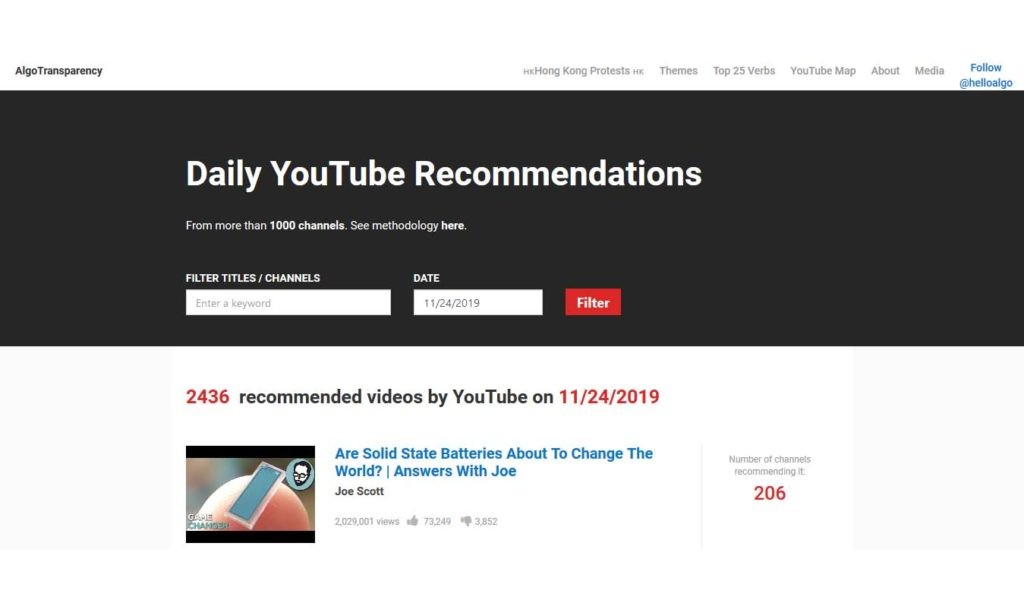

En realidad, en ninguno. YouTube prioriza los vídeos que generan más engagement con el objetivo de que los usuarios pasen más tiempo en su plataforma. Una dinámica que está teniendo consecuencias en la forma en que percibimos nuestro entorno. Al menos, así lo entiende Guillaume Chaslot, exingeniero de Google y fundador de Algotransparency.org, una plataforma que busca sacar a la luz las consecuencias de determinadas decisiones algorítmicas en nuestra sociedad.

Chaslot, programador y doctor por la Universidad de Maastricht, en los Países Bajos, es también asesor del Center for Humane Technology. En los últimos años, ha dedicado gran parte de su trabajo a estudiar cómo las redes neuronales, el tipo de inteligencia artificial en que se basa el sistema de recomendación de YouTube, amplifican los discursos extremos por encima de cualquier otro contenido.

– Trabajas en YouTube hasta 2011, ¿por qué dejas la compañía?

Quería trabajar y profundizar más en el tema de los filtros burbuja, por qué las redes sociales crean burbujas de opinión que solo refuerzan los puntos de vista del usuario. Pero Google no estaba interesado en gastar demasiado tiempo en estos temas. No podíamos dedicarle más del 20% del tiempo del proyecto, pero yo sentía que no era suficiente.

Un día, mi mánager me dijo que dejase de trabajar en ese tema, que no le dedicase más recursos. No lo hice y me despidieron.

«Cuando trabajaba en YouTube, ni siquiera conocíamos en detalle qué estábamos haciendo. No analizábamos nunca las consecuencias de lo hacíamos».

– Tras YouTube, probaste con otros proyectos. Por ejemplo, Bayes Impact, fundado por Paul Duan, otro exingeniero de Silicon Valley. ¿Por qué crees que hay tantos ingenieros de las grandes tecnológicas que abandonan el barco y se dedican a trabajar para visibilizar la cara B de estas compañías?

Bueno… Es que existen una serie de malas prácticas que se mantienen en aras de generar beneficios. Y existen ciertos tipos de personas que quieren que se hable de ellas, que la sociedad las conozca.

– Más tarde, en 2017, decides fundar Algotransparency.org. El objetivo de esta web es analizar el impacto de los algoritmos de recomendación de YouTube. ¿No se supone que, como ingeniero que trabajó en esos algoritmos, deberías conocer ya dicho impacto?

Como ingeniero, sabes cómo funciona, cómo está programado. Pero desconoces cuál es su impacto real, qué es lo que consigue. Cuando lo estaba programando en 2010, no tenía forma de saber qué efectos iba a tener en 2019. Por eso cree AlgoTransparency, para entender realmente cuáles eran los efectos del algoritmo de recomendación de YouTube.

En 2010 y 2011, cuando trabajaba en YouTube, ni siquiera conocíamos en detalle qué estábamos haciendo. Nos guiábamos por las métricas. No analizábamos nunca las consecuencias de lo que estábamos haciendo.

– ¿Cómo funciona el software de AlgoTransparency?

Analizamos el contenido de 1.000 canales diferentes y las recomendaciones que parten de ellos. Dentro de cada canal analizamos los vídeos y las recomendaciones que surgen de cada vídeo. Así, podemos señalar cuáles son los vídeos que prefiere destacar el algoritmo de YouTube. Si visitas la web, puedes ver los vídeos preferidos por el algoritmo en un día determinado o dentro de un tema concreto.

«Los vídeos más agresivos y los más extremos tienen mejores resultados en términos de engagement y, como tal, son los que más tiende a recomendar el algoritmo».

– ¿Qué habéis conseguido descubrir a través de esta herramienta?

Hemos descubierto que existen ciertos tipos de vídeos que son recomendados con mucha frecuencia, como los de teorías de la conspiración. En los últimos tiempos han perdido peso, pero todavía hay ciertos días en los que el algoritmo les otorga mucha visibilidad, los promociona por encima de otro contenido. Por ejemplo, el pasado día 17 de noviembre, el vídeo más recomendado de la plataforma fue una teoría de la conspiración sobre las pirámides de Egipto.

Como regla general, también hemos descubierto que los vídeos más agresivos y los más extremos tienen mejores resultados en términos de engagement y, como tal, son los que más tiende a recomendar el algoritmo. Los vídeos violentos pueden parecer importantes, llevan al clic. En el fondo no es más que otra forma de clickbait. Y el algoritmo se encarga de amplificar ese clickbait.

– ¿Cuál es el objetivo que persigue YouTube con esto?

Engagement. El algoritmo está llevando a toda una generación a consumir contenido más extremo solo para conseguir que los usuarios consuman más vídeos y pasen más tiempo en la plataforma. Lo hace para mantenernos pegados a la pantalla.

– ¿Y cuáles son las consecuencias de esta espiral de recomendaciones?

Crea una sociedad más dividida, hipersegmentada, más agresiva y, en definitiva, más ineficiente.

– Cada vez que se toca este tema, las redes sociales esquivan su responsabilidad. Siempre señalan a los creadores y se escudan en que las plataformas son solo canales de distribución.

Evidentemente, estas empresas no quieren asumir su responsabilidad. Pero eso no quiere decir que no sean, al menos parcialmente, responsables de amplificar ciertos contenidos. Son responsables en la medida en que han diseñado los algoritmos.

Es cierto que no se trata del mismo nivel de responsabilidad que, por ejemplo, una empresa editora de un medio de comunicación. Pero no se puede ignorar que sus algoritmos están creando problemas que tienen que ser solucionados.

«Necesitamos más información transparente y nuevas regulaciones adaptadas a los nuevos problemas. Si no cambiamos nada, las redes sociales seguirán creando una sociedad más dividida y agresiva».

– ¿Cómo podemos solucionar este reto? ¿Cuál es la salida?

Las empresas que están detrás de las redes sociales, por sí mismas, van a hacer el mínimo trabajo necesario. Van a solucionar ciertas cosas, pero la base no va a cambiar. La solución puede seguir dos caminos. O los usuarios están mejor informados y se dan cuenta de lo que está pasando y abandonan la plataforma. O establecemos mejores sistemas de rendición de cuentas.

Creo que, en un principio, éramos muy pocos los que hablábamos de estos temas. Cuando empecé, llegué a pensar que el problema lo tenía yo. Pero poco a poco nos hemos ido dando cuenta de que muchos millones de personas comparten las mismas preocupaciones.

Así que, por un lado, necesitamos más información transparente y, por otro, nuevas regulaciones adaptadas a los nuevos problemas. Si no cambiamos nada, las redes sociales seguirán creando una sociedad más dividida y agresiva.

– Cuando los que somos ajenos al mundo de los programadores pensamos en algoritmos, nos imaginamos algo que está por encima de todos, puro y objetivo. Pero, en realidad, están diseñados por personas, con sus sesgos y prejuicios. Personas que, como decías, puede que ni siquiera tengan claros los impactos de su trabajo.

Necesitamos crear algoritmos lo más justos posibles, tecnología que no amplifique nuestros sesgos, que no discrimine. Pero no es nada sencillo. Es un tema en el que estoy trabajando ahora mismo y me estoy dando cuenta de la complejidad que entraña.

«En YouTube no descubrimos nada nuevo. Vemos lo que nos quiere mostrar el algoritmo con el único propósito de que no dejemos de consumir».

– ¿Crees que las redes sociales han subestimado el poder de los algoritmos de recomendación y de la inteligencia artificial?

El problema principal es que los sistemas de recomendación no están sometidos a ningún tipo de control por parte del usuario. Creemos que estamos decidiendo qué ver, que estamos descubriendo contenido. Pero es el algoritmo el que decide qué es lo que vamos a ver de entre miles de millones de vídeos. Cuando hacemos clic, más del 99,9% del peso de la decisión recae en el algoritmo.

El algoritmo diseña el camino y la dirección que vamos a tomar. El usuario solo tiene el control sobre dónde poner el pie para dar el siguiente paso. En YouTube no descubrimos nada nuevo. Vemos lo que nos quiere mostrar el algoritmo con el único propósito de que no dejemos de consumir.

En un principio, el sistema de recomendación puede tener consecuencias inocuas. Pero hemos probado que a la larga acaba llevándonos a contenidos extremos, bulos y teorías de la conspiración porque generan más engagement.

– Otra de las conclusiones que habéis extraído es que, a la larga, los algoritmos son entrenados por los usuarios que más usan la plataforma. Es decir, aprenden más de los hábitos de la gente que se pasa horas viendo vídeos que del usuario medio.

El algoritmo de recomendación de YouTube le da más peso al contenido que consumen los superusuarios de la plataforma. Y luego acaba dirigiendo al resto de usuarios a los vídeos que consumen estos espectadores frecuentes. Esto acaba creando una serie de burbujas concretas que terminan por alterar la imagen que tenemos del mundo. Si la mayoría de vídeos que vemos muestran una visión muy concreta de las cosas, acabaremos pensando que esa es la realidad.

– Cada vez más grupos aprenden a sacar partido del funcionamiento de las redes sociales para extender sus discursos. Algunos de ellos con visiones extremas o claramente negativas para la sociedad. ¿Cómo podemos evitar amplificar esos discursos mientras protegemos el derecho a la libertad de expresión?

En realidad, ambas cosas no tienen por qué estar relacionadas. No tenemos un problema con la libertad de expresión. Tenemos un problema con cómo los algoritmos de las redes sociales amplifican ciertos discursos extremos. No haría falta que las redes sociales bloqueasen el discurso del odio, discursos de extrema izquierda o contenido de extremistas religiosos si no lo amplificasen por encima de otros discursos tal como están haciendo.

No hablamos de libertad de expresión. Hablamos de libertad algorítmica, algo que yo creo que no está protegido en ninguna constitución. Cualquier discurso debe tener cabida en las redes sociales. Lo que tenemos que controlar es cómo los algoritmos utilizan determinados discursos en beneficio de la plataforma.

– ¿Crees que este tipo de comportamiento algorítmico, que esta obsesión con el engagement, está afectando a otros sectores, como, por ejemplo, los medios de comunicación?

Sí, claro que está afectando. Los medios de comunicación no pueden ser ajenos a las redes sociales. Además, para poder sacarle partido a estas herramientas de comunicación acaban haciendo lo mismo y copian el tipo de contenido que recomiendan los algoritmos. En lugar de amplificar contenido veraz e informativo, amplifican contenido extremo, conspiraciones y bulos. Y eso les está funcionando en la esfera online en la que los ingresos llegan solo a través de la publicidad y se busca maximizar el número de usuarios.

En Nobbot | Somos carne de «fake news»: No dejes que la realidad te estropee un buen prejuicio

Imágenes | Guillaume Chaslot, AlgoTransparency, Unsplash/Kon Karampelas, Stock Photography