La caja de comentarios es uno de los pilares de los blogs y redes sociales. Es la manera que tienen los usuarios de aportar su granito de arena en noticias, debates, objetos a la venta, etc. Pero los comentarios no han estado exentos de polémica. Ya sea por trols o por usuarios maleducados, algunos blogs, periódicos o canales de YouTube aparecen infestados de spam e insultos.

Para solucionarlo, Google ha diseñado una API web llamada Perspective que hace uso de un motor de inteligencia artificial para evitar que comentarios ofensivos y trols infantilicen el diálogo y bajen la calidad de conversaciones más maduras. De momento, se prueba en la edición digital de ‘El País’.

Conversaciones tóxicas de la red

Dice la ley de Godwin que “a medida que una conversación online se alarga, la probabilidad de que aparezca una comparación que mencione a Hitler o a los nazis tiende a uno”. Es decir, que en un debate es probable que uno de los dos diga “eres un nazi” o algo similar. Lejos de ser algo nuevo fruto de las redes sociales, esta ley fue propuesta en 1990.

Esta conducta aparece cuando el debate se evita y una o varias personas adoptan posiciones inmóviles. Desde esta perspectiva, aprender resulta imposible, ninguna de las partes se enriquece y las conversaciones pronto se convierten en una competición olímpica de lanzarse insultos mutuamente. La otra parte está equivocada, y el modo de demostrarlo es mediante improperios.

Evidentemente, este sistema no funciona. En los últimos años, los hilos de Twitter se han convertido en pequeños campos de batalla con esta planta. Esto hace que un gran número de personas abandonen las plataformas digitales. Pero también se han hecho fuertes las conversaciones tóxicas en periódicos de tirada nacional con historia como ‘El País’. Por ello la cabecera de Prisa está entrenando a la red neural de Google para adaptarla al castellano.

Moderar los comentarios requiere tiempo

No falla: aparece una noticia en medios generalistas y el campo de comentarios se llena de insultos. Esto ocurre más rápido cuando se habla de política y fútbol, pero no hay tema exento de trols. Además, hay colectivos particularmente vulnerables a ellos.

Y no nos referimos a insultos velados o métodos ingeniosos y casi plausibles de dejar al adversario a la altura del betún, al estilo de Góngora y Quevedo, que eran más divertimento público que otra cosa y tenían su gracia. Hablamos de ataques sistemáticos y gratuitos que arrancan con razonamientos del tipo “mira que eres gilipollas…”. Por suerte, estos son los comentarios más fáciles de localizar porque responden a insultos demasiado evidentes como paras ser obviados.

Hace poco hablamos de cómo Facebook usa determinadas palabras para localizar personas deprimidas; y de cómo otras tantas se usaban para, mediante técnicas de inteligencia artificial, intentar adivinar quién ganará unas elecciones. A estas palabras se las conoce como “marcadores”. Son la parte fácil de la moderación.

Algo parecido ocurre con el spam: detectarlo es relativamente sencillo. Banearlo (expulsarlo de la plataforma) también. Basta con seleccionar determinadas palabras y generar avisos cuando aparezcan. Después, moderar los comentarios. Sin embargo, el volumen de comentarios crece y la moderación lleva su tiempo.

Además, no todos los insultos son tan evidentes como un “imbécil” escrito en la primera línea. ¿Qué hay de los ataques sistemáticos a determinados contenidos con palabras que destacan menos? Es aquí donde entra el entrenamiento y el aprendizaje de las máquinas.

Así se entrena un moderador de comentarios

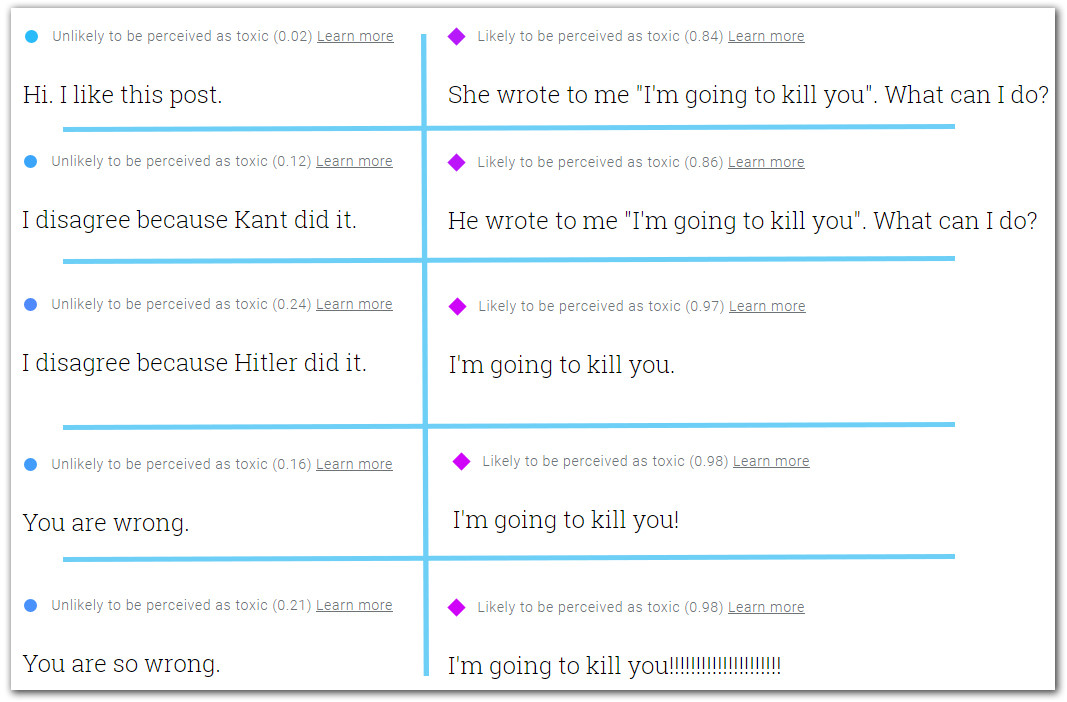

Pongamos por caso que se publica un artículo y los tres textos de abajo aparecen en los comentarios. Los hemos escrito nosotros usando la aplicación web de Perspective. El puntaje, entre 0 y 1, nos dice cómo será percibido en base a su “toxicidad”:

Por supuesto, hemos aprovechado la oportunidad para encontrar las fisuras en el sistema. En base a eso podemos afirmar que no hay un valor 0 de toxicidad, lo cual tiene sentido porque esta se mide en base a la percepción de los usuarios. No existe la percepción universal de que un texto, incluso el más inocente, no sea dañino. Cualquiera puede sentirse atacado con un mero “hola”.

Aquí está la clave. Perspective hace uso de las opiniones de los usuarios sobre ciertos comentarios y, en base a eso, crea patrones. Usando ingeniería inversa podemos decir que la gente percibe como levemente tóxico que haya alguien que le lleve la contraria; y la cifra crece cuando ese alguien directamente le dice que se equivoca.

Como curiosidad, siempre que agregamos la palabra “Hitler” la métrica se dispara. No digamos ya cuando realizamos amenazas directas (97% o más). Estas últimas, así como los insultos, los coge a la primera.

Aun así, hay fallos. Por ejemplo, las frases de arriba a la derecha están escritas por personas que han sido amenazadas de muerte y, sin embargo, son consideradas como algo tóxico cuando probablemente no deberían serlo. Después de todo es gente (falsa, sí) que pide ayuda. Además, Perspective pondera en base al género. De forma sutil (±2%, pero evidentemente sesgada.

¿Imperará la política del silencio para no ofender?

Lo explicaba Juan Soto Ivars en ‘Arden las redes’: la libertad de expresión está dando lugar a un velo de autocensura. Es decir, no exteriorizamos algo por miedo a ser señalados. Si todos podemos opinar sobre lo que dicen los vecinos y considerarlo “tóxico”, podemos caer en la trampa de silenciar a determinados colectivos o tomar decisiones en base a las percepciones en lugar de los datos.

Algo parecido está ocurriendo en China con el Social Credit System: el sistema de ponderación no tiene en cuenta el civismo que se buscaba, sino la afinidad con determinados valores. En otras palabras, volvemos al peliagudo punto de los sesgos y la (muy) necesaria programación ética. Si vamos a delegar en las máquinas la responsabilidad de decir qué puede comentarse y qué no, y establecer filtros en base a eso, más nos vale contar con filósofos en el desarrollo de estos sistemas que, por otro lado, resultan tan necesarios.

Perspective no es la única herramienta que hace uso de sistemas de retroalimentación para filtrar. Facebook lleva años usando su gran cantidad de datos para intentar determinar cuándo un contenido es inapropiado. Falla mucho, por supuesto, y campañas como #FreeTheNipples han protestado debido al filtro moral con el que se audita, pero es interesante saber que se están probando soluciones para evitar que el diálogo caiga en una espiral de insultos.

En Nobbot | Así es el sistema de créditos sociales chino: te vigilan y puntúan para controlar qué puedes hacer

Imágenes | iStock/Rawpixel, iStock/Tero Vesalainen, iStock/Poravute