Más allá de quienes beben desinfectante para limpiar el virus o quienes toman medicinas de eficacia dudosa contra la COVID-19, ¿cuáles son los riesgos reales de la desinformación durante la pandemia?

La existencia de grupos que rechazan las vacunas puede poner en riesgo la inmunidad de poblaciones enteras. Y las teorías conspirativas menoscaban la credibilidad de expertos e instituciones sanitarias, dejando un rastro de desconfianza a su paso. La desinformación es un fenómeno complejo, alimentado tanto desde organizaciones con intereses claros como desde nuestros propios sesgos humanos.

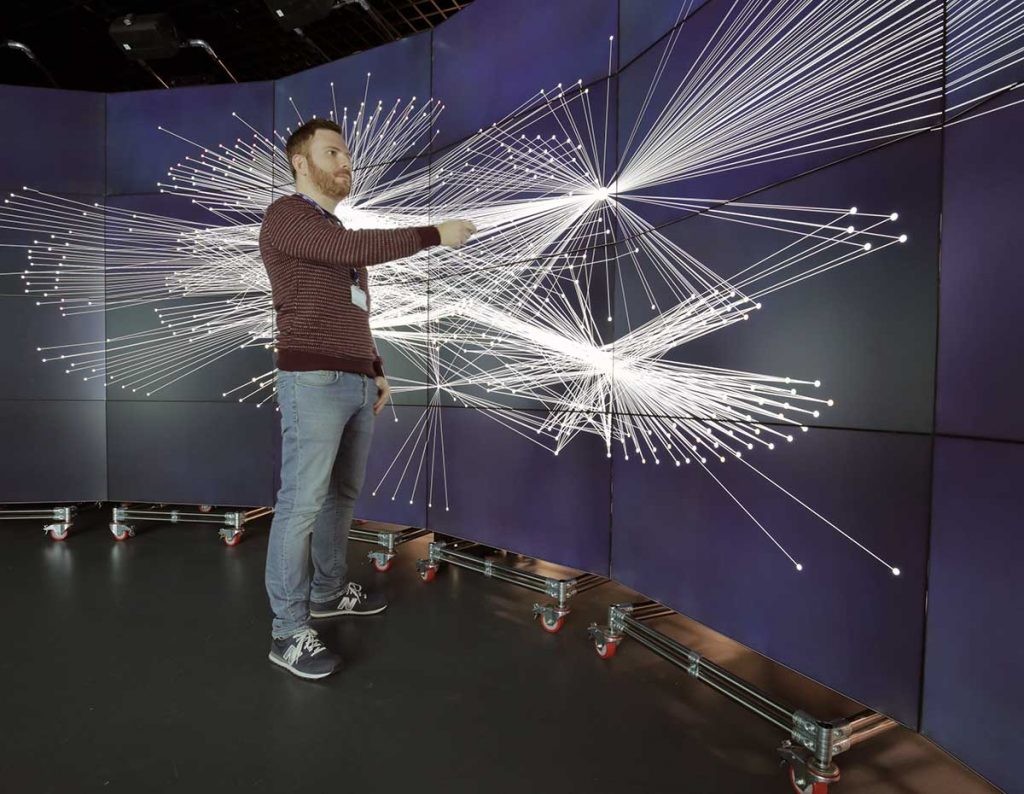

Juan Gómez Romero y Miguel Molina Solana, del Departamento de Ciencias de la Computación de la Universidad de Granada (UGR), trabajan para desenmascarar la desinformación en redes con las herramientas que nos dan las matemáticas y la inteligencia artificial. Su último paper, publicado junto a varios colaboradores del Imperial College de Londres (Reino Unido) y que analiza las fake news durante las últimas elecciones de Estados Unidos, ha dado bastante que hablar. Pero la desinformación no se frena y sigue evolucionando.

– Vuestro estudio sobre la desinformación en Twitter se basa en las elecciones estadounidenses de 2016. ¿Todo empezó allí?

En parte sí, pero no solo. El origen de la investigación está en un trabajo que se inició en el Imperial College de Londres, donde Miguel [Molina Solana] trabajaba y yo estaba haciendo una estancia. La experiencia del Brexit, donde ya se habían visto campañas de desinformación, estaba muy reciente. Las elecciones de Estados Unidos estaban a la vuelta de la esquina y estaban apareciendo movimientos similares. También fue entonces cuando el término fake news empezó a utilizarse de forma generalizada.

Las elecciones se convirtieron, tanto por el desarrollo de la campaña como por sus resultados, en algo muy relevante para el estudio de la desinformación. Por eso decidimos centrar nuestro trabajo en ellas.

– ¿Y por qué Twitter?

Sobre todo, porque recopilar información de una red abierta como Twitter es relativamente fácil si lo comparamos con otras redes sociales. Además, en 2016 las condiciones de uso de Twitter permitían acceder a esa información de forma aún más sencilla que ahora.

– ¿Cómo se diseña un algoritmo para que detecte noticias falsas?

No es una respuesta que se de en un minuto, pero nosotros lo abordamos de la siguiente manera. Primero nos dimos cuenta de que la mayoría de los tuits con fake news o noticias poco contrastadas compartían una serie de características, más o menos obvias. Así, empezamos por estudiar si podíamos cuantificar esas características y comprobar si eran comunes a esos mensajes. El objetivo final era que, observando esas características, pudiésemos asignar las probabilidades de que un tuit contuviese información falsa.

El siguiente paso, en el que estamos trabajando ahora, es no tener que definir esas características a priori, porque es difícil ser exhaustivo y porque estas cambian mucho. Estamos aplicando técnicas de inteligencia artificial (IA) y de deep learning que identifiquen estas características de forma automática.

«Siempre habrá quien tome por cierta una noticia de ‘El Mundo Today’. Si las personas lo hacemos, las máquinas también»

– Si los seres humanos nos creemos constantemente noticias falsas, por mucho que estemos prevenidos, ¿cómo evitarlo con matemáticas?

Es difícil tanto por el carácter cambiante de las características de las fake news como por el esfuerzo que se hace por difundirlas desde determinadas organizaciones. La desinformación cada vez es más sutil.

Para abordar esta complejidad debemos hacerlo desde una perspectiva multidisciplinar. Nosotros nos centramos en la parte computacional, en todo lo que podemos medir: la forma, el significado, el contexto, el origen, el mensajero… Todas estas características pueden convertirse en datos y patrones. Todos estos datos tienen que poder ser interpretados en contextos políticos y socioculturales más amplios. Para ello es necesario apoyarse en otros campos del conocimiento.

– En Twitter y en otras redes sociales las fronteras entre bromas, ironías y noticias están borrosas. ¿Es posible que una inteligencia artificial llegue a entenderlas?

Esta es una de las partes más complicadas del procesamiento del lenguaje, pero también es un campo en el que se han producido grandes avances. Los modelos matemáticos de inteligencia artificial son cada vez más capaces de recoger el sentido de los textos y, hasta cierto punto, distinguir si se trata de sarcasmo o ironía, por ejemplo.

De todas formas, es un problema que no está resuelto y que quizá no lo esté nunca. Las mismas personas a veces tenemos dificultades para distinguir el humor o la ironía. Siempre habrá quien tome por cierta una noticia de ‘El Mundo Today’. Si las personas lo hacemos, las máquinas también.

– ¿De qué manera ayuda el comportamiento del usuario a detectar noticias falsas?

Al final, un tuit es el resultado de un proceso amplio. No es algo aislado. Datos como cuándo se ha creado una cuenta, si es o no activa en un tema determinado o si tiene un historial previo de informaciones sospechosas pueden indicar que existe una tendencia a publicar fake news. Esto en relación a usuarios humanos. Si hablamos de bots o usuarios automatizados sí que existen una serie de patrones más claros, aunque cada vez son más sofisticados.

– Algunos estudios señalan también la importancia de los patrones de difusión de los mensajes, al menos para detectar campañas de desinformación intencionadas.

En nuestro trabajo nos fijamos más en los tuits concretos, sin entrar tanto en los usuarios o en los esquemas de propagación o de viralidad. Pero sí es una línea en la que estamos trabajando, estudiar la red de retuits y de interacciones de los propios usuarios. Esos patrones de difusión contienen una serie de características que nos pueden servir para detectar comportamientos que no son habituales.

«Hay usuarios muy activos que logran convertir las ‘fake news’ en virales. Son los supercontagiadores de bulos»

– De la misma manera en que hablamos de supercontagiadores de la COVID-19, ¿existen los superdifusores de bulos?

Sin duda, tanto humanos como bots. Periódicamente se detectan campañas automatizadas o incluso el propio Twitter cierra una serie de cuentas porque detecta una organización dedicada a difundir cierto tipo de desinformaciones. Esto se hace siempre a través de usuarios muy activos que logran convertir las fake news en virales. Ahí entran en juego esos supercontagiadores de bulos. Es algo que cada vez se intenta hacer de forma más sutil, para no levantar sospechas.

– ¿Para qué nos debe servir detectar los bulos: para retirarlos de la red o para advertir a los usuarios?

Nosotros somos más partidarios del aviso que de la retirada. Es un problema muy complejo y que no está bien definido. Dentro de las fake news hay muchas categorías diferentes y la separación entre ellas no siempre está clara. Retirar una noticia de forma automática es complicado. Los algoritmos deben ayudar, pero no deberían tener una capacidad de decisión definitiva.

Somos partidarios de que las herramientas automáticas ayuden a las organizaciones que se encargan de detectar bulos, como las plataformas de verificación o fact-checking, y al usuario a conocer mejor a qué se enfrenta. Son herramientas que así pueden servir para frenar la propagación de noticias dudosas que, al fin y al cabo, es lo más importante.

«Twitter no es un medio de comunicación y su objetivo principal no es difundir información verificada»

– Las empresas detrás de las grandes redes sociales se muestran preocupadas por la difusión de bulos, pero al mismo tiempo viven gracias a la viralidad y la polarización que generan las fake news. ¿Es una batalla perdida?

Es necesario encontrar un equilibrio entre los intereses de las compañías y los que, desde fuera, intentamos luchar contra este tipo de problemas. Twitter no es un medio de comunicación y su objetivo principal no es difundir información verificada, por lo que es normal que a veces choquen los intereses.

Al mismo tiempo, existe un interés por parte de las redes sociales para que su imagen no se asocie a la difusión de fake news, porque sería algo que expulsaría a muchos usuarios. Además, definir la responsabilidad de la información que circula en las redes sociales es complicado. Las empresas que ponen la tecnología y la plataforma pueden tener algo de responsabilidad, pero no toda.

– Volviendo sobre vuestro trabajo, ¿podría llegar a convertirse en una herramienta que estuviese siempre activa, que no analizase las fake news del pasado, sino que funcionase en tiempo real?

Nuestro objetivo es identificar los patrones del pasado para después identificarlos en la actualidad. La idea, la esperanza, es que lo que ocurre ahora se parezca a lo que ocurrió antes. Esto no es siempre aplicable, porque surgen nuevas herramientas y nuevos fenómenos. Pero el entrenamiento de las redes neuronales debe hacerse a partir de datos objetivos de fenómenos bien conocidos que ya han sucedido.

– La COVID-19 ha provocado una explosión de bulos, muchos de ellos relacionados directamente con la salud y la seguridad. ¿Nos han quedado más claros los peligros de la desinformación?

La pandemia es el fenómeno más relevante a nivel mundial ahora mismo. Se están dando todos los problemas de la desinformación que ya conocíamos de otros eventos y muchos problemas nuevos. Además, podemos esperar que aparezcan en el futuro cercano otros eventos que generen problemas a nivel bulos y calidad de la información como, por ejemplo, cuando aparezcan las primeras vacunas.

Desde un punto de vista personal, creo que a nivel usuario con la pandemia nos han quedado más claros los riesgos de la desinformación. Ahora mismo el problema de las fake news está sobre la mesa y cada uno lo va procesando a su manera. Creo que mucha gente es más consciente de su existencia, porque nos afecta en una situación cercana, con riesgos que se vinculan directamente con nuestra salud.

«Somos capaces de asumir información errónea o poco contrastada simplemente porque se ajusta bien a lo que nosotros pensamos o porque nos tranquiliza ante la incertidumbre»

– Desde el punto de vista del razonamiento humano, ¿qué crees que nos lleva a creer bulos sobre una enfermedad que vivimos tan de cerca en lugar de confiar en las fuentes expertas?

No es mi campo de trabajo y habrá compañeros que puedan explayarse más sobre ello. Pero, en general, una cuestión que aparece de forma recurrente en temas de desinformación es el llamado sesgo de confirmación. La inclinación que todas las personas tenemos a buscar información que se ajusta a nuestras ideas y a nuestra forma de entender el mundo.

A veces, somos capaces de asumir información errónea o poco contrastada simplemente porque se ajusta bien a lo que nosotros pensamos o porque nos tranquiliza ante la incertidumbre. Buscamos información que nos confirme. Este sesgo es una fuerza muy poderosa. Nos hace ser menos críticos y propagar todo aquello que refuerza nuestra propia forma de pensar.

– ¿Qué es más factible: que todos lleguemos a ser conscientes de nuestros sesgos y desarrollemos el pensamiento crítico ante los mensajes que nos llegan por redes o crear una IA capaz de detectar los bulos sin margen de error?

Conseguirlo al cien por cien en ambos casos es casi imposible o, al menos, está muy lejos. Ambas cosas no dejan de estar relacionadas. Mientras las personas queramos transmitir desinformación o haya interés en que se siga haciendo, continuaremos logrando engañar a las inteligencias artificiales.

Nuestra visión es la de crear herramientas tecnológicas que permitan potenciar y reforzar la actitud crítica de las personas. Hoy por hoy, disponemos de tecnologías que nos saturan de información. Deberíamos tener también tecnologías que nos ayuden a filtrarla. La esperanza es que con mejores herramientas y más pensamiento crítico podamos llegar a una situación en que todos seamos conscientes de la desinformación y trabajemos para combatirla dentro de nuestras posibilidades.

«Si todo parece que es falso, cada uno puede crearse su propia verdad y creer lo que mejor le parezca»

– El tema de los intereses, de las intenciones, es clave. ¿Qué nos lleva a querer desinformar?

Existe una gran diferencia entre las campañas organizadas y la desinformación que parte de los individuos. En la parte personal, creo que la reafirmación, ese sesgo del que hablábamos antes y otros sentimientos como la indignación o el deseo de comunicarnos con nuestro entorno nos llevan a difundir bulos.

En cuanto a la desinformación organizada y global, los intereses son múltiples. Van desde promover algunos discursos políticos para influir en la opinión pública hasta desestabilizar y crear un clima general de desconfianza. Si todo parece que es falso, cada uno puede crearse su propia verdad y creer lo que mejor le parezca.

Una sociedad democrática y libre necesita una serie de pilares y uno de ellos es la información veraz y la confianza en las instituciones. Si se socaban estos pilares, se logra desestabilizar la sociedad. Esto es un problema real que, de hecho, está recogido en las estrategias de seguridad tanto a nivel español como europeo.

En Nobbot | ¿Nos podemos defender de los bulos? Ella tiene la respuesta

Imágenes | UGR